El lenguaje que empleó la revista científica Nature resultó bastante moderado para un tema tan alarmante. Sus editores afirmaron que ChatGPT y otras aplicaciones de inteligencia artificial (IA) similares amenazan “la transparencia y la confiabilidad en las que se basa el proceso de generación de conocimiento… en última instancia, la investigación debe tener transparencia en los métodos, y contar con la integridad y veracidad de los autores”. El editor de Science, publicación rival de Nature, arremetió en el mismo sentido: “Un programa de IA no puede ser un autor. Una violación de estas políticas constituirá un fraude científico equiparable a la alteración de imágenes o al plagio de trabajos existentes”, escribió.

Pueden parecer advertencias sutiles, pero para los académicos que mandan trabajos de investigación a revistas arbitradas como Science y Nature, la posibilidad de ser acusados de fraude científico –acusación que tiene el potencial de arruinar su carrera– por utilizar inteligencia artificial es tan sutil como una sirena antibombardeo. Es un letrero de neón rojo brillante que dice en mayúsculas: “No pase”.

Esta reacción exaltada no fue resultado de supuestos hipotéticos. Tan solo unos días antes, periodistas de Nature habían revelado que los resúmenes escritos por ChatGPT eran lo suficientemente científicos como para engañar a otros académicos y, peor aun, que artículos escritos en coautoría con IA ya se estaban abriendo camino en la literatura arbitrada. Así como los profesores universitarios han comenzado a encontrarse ensayos escritos por Chat GPT en estado salvaje, así como los periodistas han descubierto notas escritas por aplicaciones de IA, las revistas científicas de repente se dieron cuenta de que la amenaza abstracta de artículos de “investigación” escritos por máquinas es muy, muy concreta. Pareciera que estamos a semanas de que un tsunami de artículos falsos golpee a las revistas arbitradas, inundando a los editores y ahogando el proceso científico en un océano de basura.

Las revistas tienen toda la razón al preocuparse. ChatGPT y, es de suponerse, las aplicaciones de IA que le sigan, representan una potencial amenaza para la propia existencia del proceso de arbitraje o revisión por pares, un mecanismo fundamental que rige cómo se hace la ciencia moderna. Pero la naturaleza de ese desafío no gira en torno a la rápida evolución de la IA y su capacidad de mimetizarse, sino de una enfermedad más lenta e insidiosa que radica en el corazón de nuestro proceso científico; el mismo problema que hace que la IA amenace a la docencia universitaria y al periodismo.

ChatGPT no es el primer programa capaz de escribir artículos de investigación que distrae la atención de los editores de revistas arbitradas. Durante casi dos décadas, las revistas de ciencias informáticas han estado plagadas de artículos falsos creados por un programa de computadora escrito por estudiantes de posgrado del Massachusetts Institute of Technology (MIT). Para usar este programa llamado SCIgen, basta con ingresar uno o dos nombres y, ¡listo!, el programa escupe automáticamente un trabajo de investigación en ciencias de la computación digno de enviarse a una revista o a una conferencia académica.

Digno, si ninguno de los revisores se molesta en leer el documento. Los artículos escritos por SCIgen eran tan obviamente absurdos que cualquier persona con una mínima experiencia en informática debería haber detectado que se trataba de un engaño antes de terminar el primer párrafo. Sin embargo, los artículos de SCIgen no solo pasaban regularmente el proceso de revisión por pares y llegaban a las páginas de las revistas científicas, sino que esto sucedía con tanta frecuencia que, a mediados de la década de 2010, las revistas desplegaron un detector automático para tratar de detener esta marea. Hoy en día es más difícil toparse con artículos generados en SCIgen, pero aún se les puede encontrar de vez en cuando en revistas de segunda categoría.

En aquel entonces, la verdadera historia no giraba en torno a lo sofisticado que era SCIgen; después de todo, era un código tan simple que solo podía crear un facsímil realmente malo de un artículo de investigación, que no debería engañar a nadie que haya abierto alguna vez una revista de informática. Como escribí para la revista Slate hace ocho años, “la probabilidad de que un científico informático real sea engañado por un artículo de SCIgen es aproximadamente la misma a que un especialista en lenguas clásicas confunda el pig Latin con un desconocido escrito de Catón”. Un artículo de SCIgen no debería pasar ni siquiera la revisión más superficial por parte del compañero más despistado en el campo. Sin embargo, también en este caso, los editores de la revista se inquietaron al punto de desplegar defensas automatizadas contra los ataques de SCIgen.

Esto dice mucho más sobre el proceso de revisión por pares que sobre el estado de la imitación por computadora. En teoría, el objetivo del arbitraje es que una afirmación científica sea examinada por dos, tres o más científicos de categoría similar, en busca de errores, agujeros lógicos y otros problemas. (Dice la leyenda científica que el revisor número dos es siempre difícil de complacer.) La revisión por pares es una medida de control de calidad que supuestamente garantiza que lo que se publica cumpla con un estándar mínimo determinado. No certifica que la investigación sea correcta, sino que no está del todo equivocada y que tiene algún valor para el avance del conocimiento en el campo. Y es por eso que las publicaciones revisadas por pares son mucho más valoradas en la ciencia que los artículos de prepublicación, no examinados: al poner su imprimátur en un artículo, una revista arbitrada le dice al mundo científico que se cumple ese estándar mínimo. Y para las revistas más prestigiosas del mundo científico, como Science, Nature, New England Journal of Medicine y similares, se supone que esos estándares mínimos son bastante altos.

Sin embargo, examinar un documento científico requiere de mucho pensamiento y esfuerzo, y por lo general los científicos no reciben un pago de las revistas para las que hacen todo ese trabajo. No debería sorprender que a menudo ellos, o los estudiantes de posgrado a los que obligan a hacer esta actividad, no hagan la mejor labor de revisión. A medida que aumenta el número de publicaciones y de artículos sometidos a revisión, el grupo dispuesto a realizar revisiones serias va viendo rebasada su capacidad.

Es un problema de escala: el proceso de verificación de la información es lo que le da valor a las revistas arbitradas, pero debido a que hacer bien ese proceso requiere mucho trabajo, es un cuello de botella que no puede expandirse de la misma manera que lo hacen las revistas mismas. El resultado es una disminución casi inevitable en la calidad de la revisión por pares. Sin embargo, la mayoría de las revistas están más que dispuestas a asimilarla, ya que la calidad del arbitraje es casi invisible. Para la mayoría, la única señal de que las cosas andan mal es cuando la basura evidente comienza a escapársele a los árbitros: esos árbitros que le dan sentido a una publicación arbitrada.

Lo que está haciendo ChatGPT, tal como lo hizo SCIgen antes, es generar basura que (al menos hoy) no debería superar un arbitraje serio. Es cierto que ChatGPT y sus hermanos de IA similares son varios órdenes de magnitud más sofisticados que SCIgen, pero si eliminas la palabrería, gran parte de lo que producen programas es incorrecto, e incluso carece de sentido. Inventan hechos y generan fuentes falsas para respaldar sus mentiras. Una revisión por pares adecuada, que verifique las referencias y los hechos, debería detectar estos problemas.

Tomemos, por ejemplo, uno de los artículos revisados por pares que describió Nature: “¿Puede GPT-3 escribir un artículo académico sobre sí mismo, con un aporte humano mínimo?” Publicado en un servidor de preimpresión en julio, el artículo fue supuestamente rechazado por una revista y luego aceptado por otra, con revisiones. Si bien aún no conocemos la naturaleza de esas revisiones, el documento que los autores han hecho público está lleno de errores que un arbitraje competente debería detectar. Las referencias son un desastre: dos parecen estar haciendo referencia de diferentes maneras al mismo artículo en línea, el cual, cabe mencionar, parece no existir. Y si existiera, no podría contener información sobre el bot GPT-3, ya que la referencia es de cuatro años antes de su estreno. Otra referencia parece inventada. Dos de los trabajos a los que se hace referencia existen, pero una verificación superficial muestra que los contextos de esas referencias son completamente falsos: no dicen lo que dice el artículo revisado por pares. (Los investigadores que enviaron el documento, felizmente, notaron que las referencias no tenían sentido.) Más importante: el texto generado por IA era anodino y sin información; no añadió nada a la comprensión de nadie. Por su misma constitución, el bot es incapaz de desarrollar conocimiento en el campo: es fundamentalmente una máquina de reciclaje, que regurgita de manera controlada aquello con lo que ha sido entrenada. Esa no es la manera de avanzar en el conocimiento. Por definición, no tiene lugar en una revista académica.

Las revistas arbitradas están preocupadas porque la facilidad de producir artículos atractivos pero insustanciales trae el riesgo de exponer cuán delgada es la barrera de revisión por pares que separa la ciencia real de lo absurdo. En el fondo, es la misma razón por la que los profesores universitarios y los periodistas están preocupados.

La revisión por pares es esencialmente un sistema de control de calidad informativo. Cuando los profesores califican ensayos y exámenes, están realizando una función similar: tratan de separar lo bueno de lo malo para asegurarse de que solo los estudiantes que cumplan con un conjunto mínimo de estándares obtengan el sello de aprobación de la universidad. Los periodistas en los medios de comunicación serios también están en el negocio de la discriminación informativa; en teoría, al menos, recopilan hechos y opiniones de una variedad de fuentes, y sintetizan una historia a partir de ellos, que solo después de múltiples capas de verificación de hechos y pulido editorial se presenta al público. Cuando los profesores no son capaces de distinguir entre un estudiante y una IA, o cuando los editores pulen un texto generado por GPT en lugar de descartarlo por completo, muestran que el proceso de discriminación está seriamente descompuesto.

Las opciones son abordar el problema de frente –mejorar de forma consciente los estándares, aun ante la presión para seguir creciendo, para trabajar más rápido y más barato–, o bien, dejar que estos procesos de discriminación decaigan. Por suerte, la inteligencia artificial proporciona herramientas para ayudarnos con la primera opción: por cada trabajo o ensayo escrito a través de la inteligencia artificial, esta misma puede ayudar a los científicos y profesores con exceso de trabajo a generar una revisión por pares o una calificación.

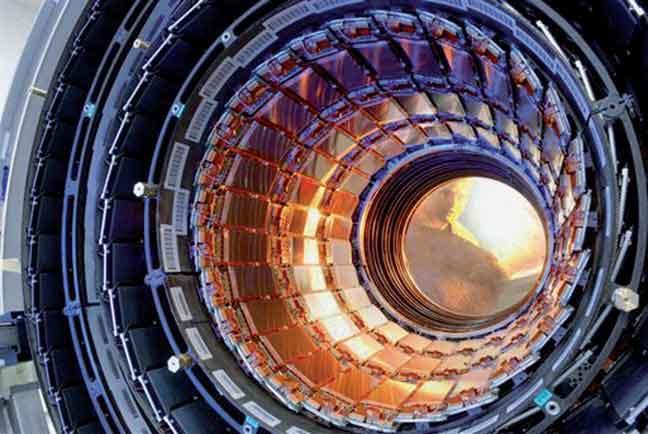

En otras palabras, si el apocalipsis de la inteligencia artificial está aquí, no es parecido a Terminator, sino a la película La idiocracia. ~

Este artículo es publicado gracias a una colaboración de Letras Libres con Future Tense, un proyecto de Slate, New America, y Arizona State University.