Hace un par de semanas circuló una nota en la que se afirmaba que un estudio realizado por la Universidad de Stanford había demostrado que una inteligencia artificial entrenada para el reconocimiento facial podía detectar, a partir de la identificación de ciertos rasgos, la preferencia sexual de una persona. Las reacciones adversas no se hicieron esperar. GLAAD y the Human Rights Campaign, organizaciones dedicadas a la defensa de los derechos LGBTQ, emitieron un comunicado conjunto en el que afirmaron que el estudio está “peligrosamente equivocado” y que la “tecnología no puede identificar la orientación sexual de las personas [sino reconocer] un patrón dentro de un subgrupo de personas blancas que lucen similares”.

A primera vista, esta tecnología suena a una vuelta al siglo XVIII y a la ya superada teoría de Antropología Criminal sobre el delincuente nato. Cesare Lombroso, su principal exponente, postulaba en el libro El hombre delincuente que un criminal y el tipo de crimen al que se dedicara podían ser identificados a partir de sus rasgos físicos (por ejemplo, señaló que los pirómanos tenían piel suave, apariencia infantil y cabellera lacia y gruesa, casi femenina). Considerada una mezcla de superstición y racismo disfrazada de ciencia, esa teoría fue dejada atrás.

Como la antropología criminal, la identificación de la orientación sexual a partir de la mera apariencia, aunque sea por medio de una inteligencia artificial, parecería estar cimentada en prejuicios. El detalle es que uno de los propósitos de la investigación era exponer los riesgos de privacidad que implica el software de reconocimiento facial. ¿Entonces todo se tergiversó? Veamos.

En primer lugar, el estudio, cuya versión final aún no es publicada, reconoce que la relación entre fisonomía y carácter se volvió tabú por la forma en que fue utilizada anteriormente para discriminar, pero señala que existen investigaciones (cuestionables, por cierto) que respaldan esa relación desde una perspectiva no tendiente al racismo. También menciona la hipótesis de que el nivel de hormonas prenatales tiene efectos en el comportamiento, la apariencia y la orientación sexual y que, de acuerdo con esta, la morfología facial y expresiones de las personas gay tienden a ser atípicas de su género biológico (de nuevo, todo cuestionable).

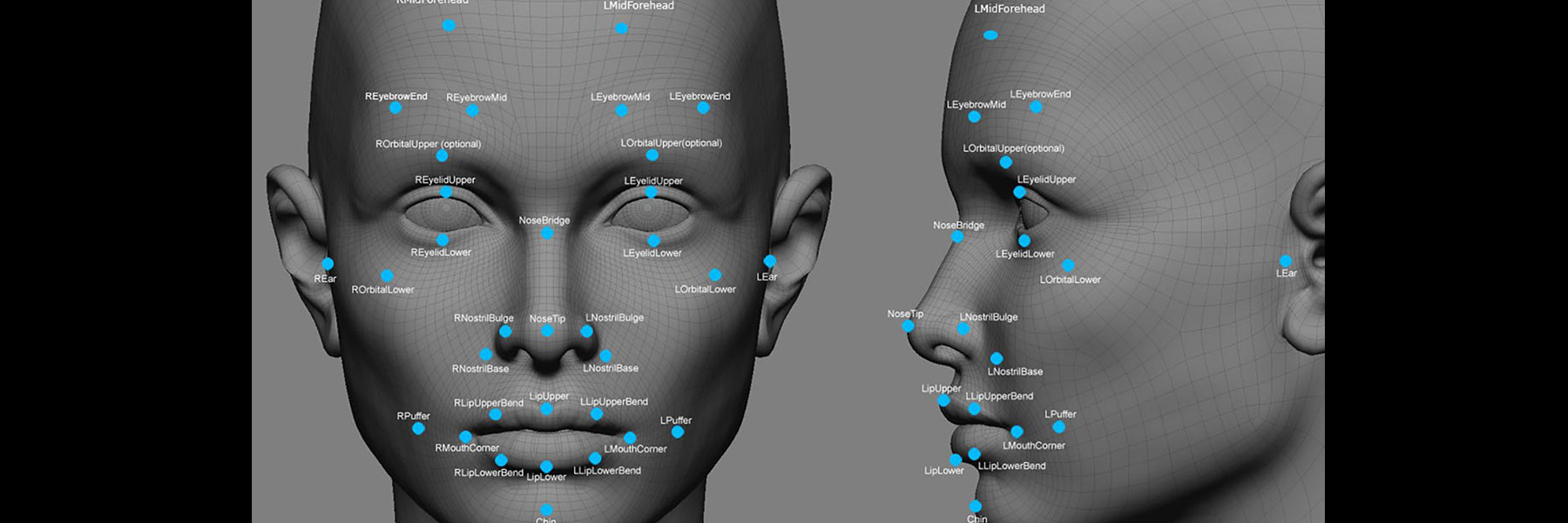

Con base en lo anterior, el estudio dice que existen características faciales típicas de las personas gay, mismas que no suelen ser adecuadamente identificadas por los humanos, pero pueden serlo por una inteligencia artificial. En el estudio, una red neuronal profunda fue alimentada con una muestra de 35,326 fotografías de perfil públicas de sitios de citas y de Facebook pertenecientes a personas abiertamente gay y heterosexuales de la cual se extrajeron los rasgos faciales de cada imagen. El algoritmo fue diseñado para identificar la orientación sexual, que los investigadores conocían de antemano, pues había sido manifestada por las personas cuya imagen se usaba. La inteligencia artificial resultó certera en un 81% para hombres y 71% para mujeres; en contraste, los humanos fueron precisos en un 61% y 54%, respectivamente. Al emitir sus conclusiones pidieron a los lectores no malinterpretar los resultados expuestos y reconocieron que la muestra carecía de variedad, ya que se limitaba a personas estadounidenses caucásicas.

¿Entonces para qué todo esto y por qué utilizaron fotografías públicas? Una de las conclusiones fue que, a diferencia de una red neuronal profunda, los humanos son muy poco precisos al tratar de identificar personas gay. Pero entre todo el ruido que generó el estudio debido a su marco teórico, casi quedó olvidado uno de sus objetivos: advertir que a través de la recolección de fotografías públicas en redes sociales, y con ayuda de herramientas comunes de machine learning, gobiernos y empresas podrían realizar este tipo de identificaciones de datos personales sensibles, tales como la preferencia sexual. Esta posibilidad resulta especialmente preocupante en países donde la homosexualidad está prohibida, y es motivo de alerta en general porque no precisa de una recolección invasiva de imágenes, puesto que puede realizarse con fotografías públicas o fácilmente disponibles. Los autores del estudio hicieron un llamado a los encargados de las políticas públicas, a las comunidades gay y a la sociedad en general para que estén conscientes del riesgo de privacidad que el reconocimiento facial puede representar.

De ahí saltamos a una de las características más novedosas del recién lanzado iPhone X: el reconocimiento facial para el desbloqueo del teléfono. “Una vez que te conoce, siempre te reconoce”, dice Apple. Muy probablemente, esta tecnología no tardará en ser adoptada por otras marcas de teléfonos inteligentes. Apple tendrá una envidiable base de datos biométricos de todos sus usuarios, aunque seguramente la cantidad y tipo de datos a los que tiene acceso y puede almacenar causará zozobra.

El reconocimiento facial por sí solo no es una herramienta nueva. Ha originado polémicas de racismo y falta de precisión. Apenas el mes pasado tuvo lugar un incidente en el que un hombre que iba trotando empujó a una mujer al arroyo vehicular en Londres. El sistema de cámaras de vigilancia identificó a un sujeto que fue arrestado y después puesto en libertad porque al momento del incidente se encontraba en Estados Unidos: se trató de una identificación errónea. Las imprecisiones de los algoritmos pueden darse por el tipo de datos con los que son entrenados. Apple aprendió de los errores ajenos y ha utilizado muestras amplias y diversas para entrenarlos, evitando así que sean tendenciosos. Otros sistemas de reconocimiento son utilizados en varios aeropuertos para comparar el rostro de la persona con el de la fotografía de su pasaporte. También ha tenido usos cuestionables por parte de los gobiernos de Rusia, China y Estados Unidos para identificar a personas que acuden a protestas, para avergonzar públicamente a los peatones que cruzan las calles donde no deben y para vigilancia extrema, respectivamente. En México, los datos biométricos se consideran datos personales, pero no sensibles, aunque existió una iniciativa de reforma a la Ley federal de protección de datos en posesión de los particulares para considerarlos como tales.

Probablemente se popularice el uso del reconocimiento facial. Con ello debemos estar conscientes de los peligros de privacidad que implica, dadas las posibilidades que permite de la mano de la inteligencia artificial: extrapolar información sensible a partir de datos que de entrada no lo son.

Nació el mismo año que se estrenó Blade Runner. Abogada, especialista en tecnología y protección de datos.