Hace unas semanas circuló la noticia de que un par de inteligencias artificiales desarrolladas por Facebook habían sido desconectadas luego de crear su propio lenguaje. Ahí empezó una retahíla de lamentaciones y especulaciones en torno al incidente, que hablaban de modernos Frankenstein o de la posibilidad de que las inteligencias artificiales hubieran creado su propio lenguaje para comunicarse en clave y destruir a la raza humana, sin que quienes las programaron se dieran cuenta de tan malignos planes. En todos estos escenarios aparecían investigadores paniqueados de lo que habían logrado esas inteligencias. Las notas parecían, aunque no del todo fake news, sí reportadas a medias, más en línea con una trama macabra de ciencia ficción que con lo que en realidad pudo haber pasado.

Aquí la transcripción del diálogo que seguro le puso los pelos de punta a Elon Musk:

Bob: “I can can I I everything else.”

Alice: “Balls have zero to me to me to me to me to me to me to me to me to.”

La inexactitud de los reportes quedó clara cuando Dhruv Batra, quien forma actualmente parte del equipo de investigación de Facebook en el tema de inteligencia artificial, dio su versión de lo que había sucedido. El incidente se debió a un error en la programación de un par de chatbots entrenados para negociar y obtener el mejor trato posible. Para comunicarse, debían utilizar el idioma inglés en forma simple, como ocurre en las conversaciones humanas (cuando éstas no son barrocas, claro está). Sin embargo, los chatbots no tenían incentivo alguno para seguir esa regla, se desviaron y empezaron a comunicarse, aparentemente sin sentido. De acuerdo con Batra, las inteligencias artificiales crearon atajos y palabras clave de la misma manera que muchas comunidades humanas lo hacen, incluso como los niños que inventan “lenguajes secretos” a prueba de adultos. ¿Qué sería lo que hablaban? ¿Slang de inteligencias artificiales? Tal vez, pero con el añadido de un entendimiento comprensión del lenguaje distinto al humano. Con licencia felina explico el ejemplo: Si voy a un refugio para adoptar cinco gatos, digo: “quiero adoptar cinco gatos”. Otro entendimiento podría decir “quiero gato gato gato gato gato”.

Que las inteligencias hayan encontrado un modo de comunicarse entre ellas podría ser benéfico para lograr una mayor interoperabilidad, sobre todo pensando en el internet de las cosas. Esto vendría a cambio de que no nos enteremos de su conversación, cosa que, de entrada, parecería sospechosa. Sin embargo, no todo lo que ocurre en una inteligencia artificial es claro para los humanos –como la toma de decisiones, cuya funcionamiento actualmente es una caja negra.

En el mismo post, Batra aclaró que no es lo mismo desconectar que hacer un cambio de parámetros. Y vaya que no es lo mismo. El cambio de parámetros sirve para añadir el incentivo que necesitan los bots para apegarse al inglés sencillo. Desconectarlos suena tan trágico como la muerte de HAL en 2001: Odisea del espacio y por supuesto que deja las cosas fuera de contexto. Con el cambio, los bots ya no podrán platicar en clave, y esta decisión nada tiene que ver con el pánico, puesto que la finalidad de los bots era interactuar con humanos de forma clara. No resultaba muy útil que una inteligencia artificial se comunicara fuera de los parámetros que la humanidad angloparlante entiende.

Una vez aclarados esos puntos, vale la pena preguntarse por qué cualquier error o imprevisto es interpretado como una señal de sublevación. Este miedo a la inteligencia artificial se alimenta con declaraciones de personajes con credibilidad, como Stephen Hawking cuando dijo que la inteligencia artificial podría acabar con la raza humana o, más recientemente, Elon Musk, quien dijo que la inteligencia artificial es más peligrosa que Corea del Norte y que, como todo lo que implica un peligro público, debe regularse (la regulación no es necesariamente mala, ni todo lo que se regula es un peligro para el público, pero esa es otra historia).

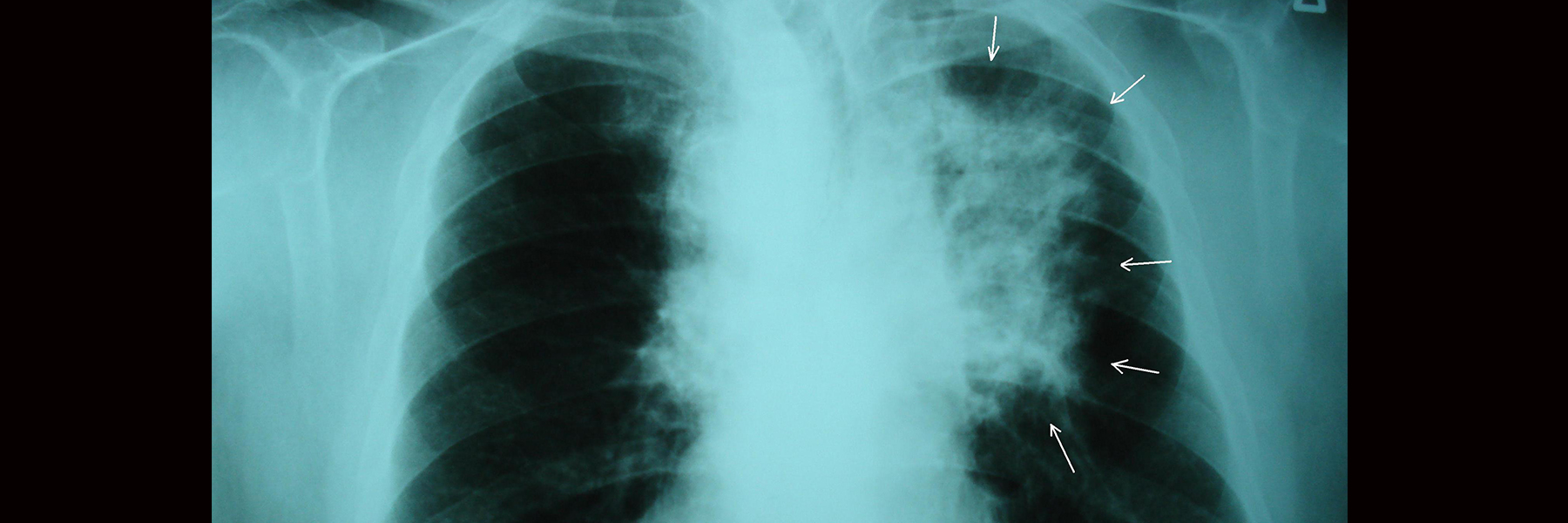

Todo esto, por supuesto tiene su contraparte. En este debate acerca de cómo los robots reestructurarán nuestras vidas en las dos décadas venideras, uno de los ponentes dio su opinión acerca de los comentarios de Hawking diciendo que es claro que el inglés es un gran experto… en física cuántica. Por otra parte, contrapuesto al punto de vista de Musk está el de Mark Zuckerberg, quien considera que la inteligencia artificial puede salvar vidas y mejorar diagnósticos, y que depende de los inventores, no de la invención, el cauce que ésta tome. Esta batalla se asemeja a la de los bastardos, pero sin ganador a la vista todavía.

La cuestión planteada nos deja preguntas interesantes: ¿por qué pensamos que las inteligencias artificiales estarían interesadas en destruir a la raza humana o ponerla en peligro? ¿Acaso pensamos que las creaciones imitarán la parte de los impulsos destructores y guerreros de sus creadores? ¿Una inteligencia artificial consciente (requisito básico para querer conquistar el mundo) se inclinaría por la destrucción humana o por la expansión de su propia consciencia? Por ahora, el interés mediático parece centrarse en el ascenso de las inteligencias artificiales y la pérdida de empleos: un Alarma!, pero con robots. Lo malo es que en la búsqueda de esa gran historia podríamos pasar de largo la del siguiente gran avance y sus potenciales beneficios.

Nació el mismo año que se estrenó Blade Runner. Abogada, especialista en tecnología y protección de datos.