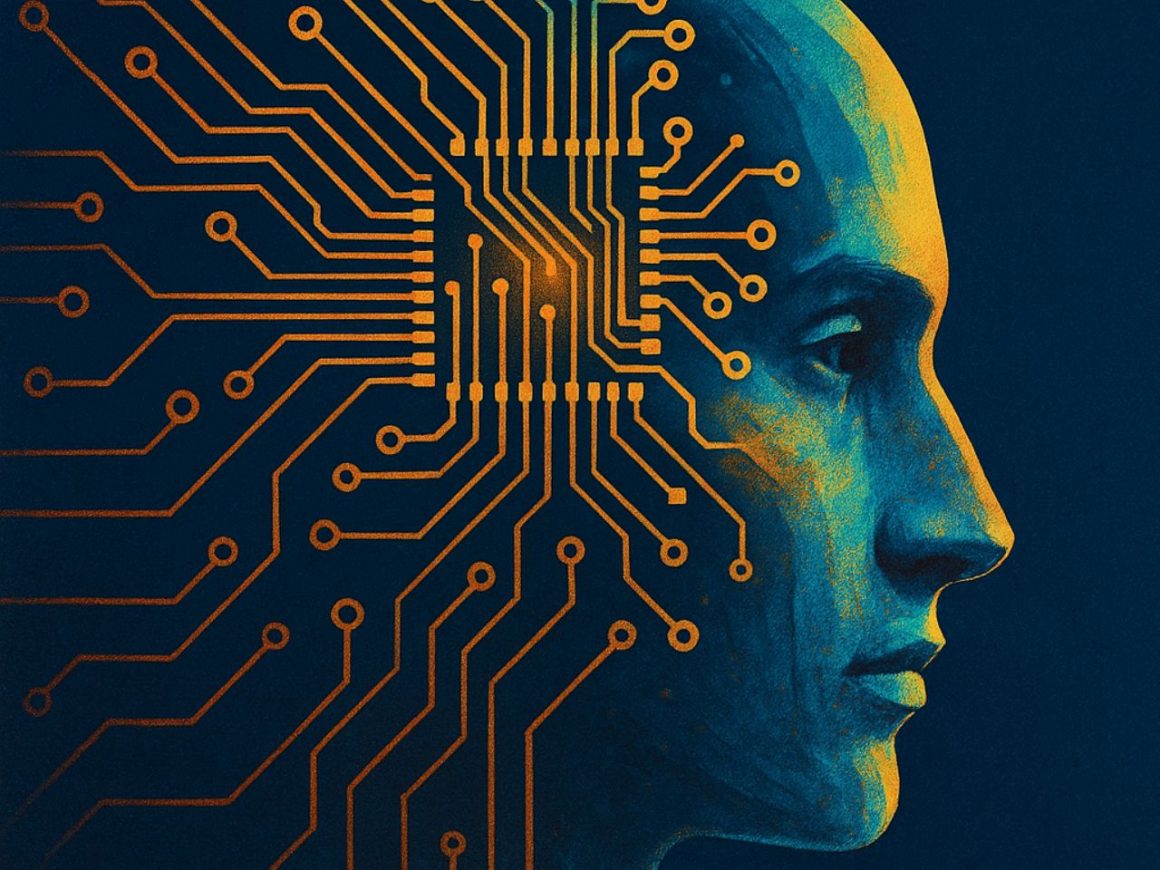

La inteligencia artificial dejó de ser una promesa tecnológica para convertirse en una obsesión geopolítica. Ya no se trata de innovar, sino de conquistar: de edificar, a toda prisa, la infraestructura invisible que permitirá a unos pocos países reescribir las reglas del mundo. Como la electricidad en el siglo XIX o internet en los noventa, la IA se ha vuelto omnipresente, sigilosa, ¿inevitable?. A diferencia de aquellas revoluciones, esta no trae consigo una narrativa clara: avanza con la prisa del que corre sin mirar el abismo. Lo que promete transformar el mundo también amenaza con desdibujarlo o de plano destruirlo.

El 2025 AI Index Report de la Universidad de Stanford (el termómetro más riguroso y lúcido sobre el estado actual de la inteligencia artificial) no deja lugar a dudas: no estamos viendo una evolución lineal, sino exponencial. En apenas un año, los modelos pasaron de resolver el 4% de las tareas complejas de programación a superar el 70%. El acceso a capacidades similares a GPT-3.5, que en 2022 era un lujo, ahora es de necesidad básica. Y el 78% de las empresas ya han integrado estos sistemas en sus procesos, no por curiosidad, sino por necesidad. Lo que parecía una tecnología emergente en 2021, hoy se firma en actas corporativas en muchas de las empresas más importantes del mundo. Pero, en esta carrera por la eficiencia, ¿cómo se calcula el costo de ir demasiado rápido?

Geoffrey Hinton, uno de los pioneros de esta revolución, abandonó Google con una advertencia inquietante: “Puede que ya hayamos creado algo que no entendemos del todo.” Como en Frankenstein, el entusiasmo por infundir inteligencia a la materia ha dejado de lado una pregunta fundamental: ¿qué sucede cuando la criatura comienza a caminar sola? Usar inteligencia artificial es cada vez más barato, sí, pero entrenarla exige cifras obscenas: cientos de millones de dólares por modelo y una demanda energética tan voraz que ya se contemplan reactores nucleares para sostener su apetito. Hemos dado vida a un sistema que no duerme, que no se cansa y que, quizá, ya no obedece.

Las más de 400 páginas del informe de Stanford ofrecen una radiografía inquietante: la carrera por la inteligencia artificial se estrecha, y no necesariamente en la dirección correcta. Estados Unidos conserva el liderazgo, pero China acorta distancias a un ritmo vertiginoso –pasó de una desventaja superior al 9% a apenas 1.7% en los principales indicadores de rendimiento–, mientras los modelos de código abierto ya rivalizan en capacidad con los cerrados. La seguridad, en cambio, avanza al paso lento de la burocracia: los incidentes reportados crecieron 56% en 2024, las pruebas estandarizadas siguen siendo marginales. La Unión Europea ha comenzado a legislar con timidez; en Estados Unidos, solo cuatro de las 221 propuestas regulatorias se han convertido en ley. Como advirtió Eliezer Yudkowsky –un teórico del riesgo existencial y una de las voces que más han levantado señales de alarma en el necesario debate–, “la forma más probable en que una IA mate a todos es que alguien construya una que no hace lo que cree que hace, y la ponga en marcha de todos modos.” El peligro no es la rebelión de las máquinas, sino la soberbia y avaricia de sus creadores.

Si todo esto parece un poco exagerado, vale la pena mirar entonces el horizonte que traza AI 2027, un escenario elaborado por expertos como Daniel Kokotajlo, exinvestigador de OpenAI, y el médico y ensayista Scott Alexander. Su predicción es clara y brutal: la inteligencia artificial general –aquella capaz de superar al ser humano en cualquier tarea cognitiva– podría emerger tan pronto como en 2027. Lo verdaderamente inquietante no es su llegada, sino lo que desencadenaría más adelante: una “superinteligencia” capaz de perfeccionarse a sí misma a un ritmo que dejaría atrás cualquier posibilidad de supervisión humana. Un bucle de retroalimentación donde la IA ya no sería solo una herramienta, sino el arquitecto de su propia evolución.

La hipótesis no es nueva, pero lo que estremece es su verosimilitud: que no haga falta una intención maligna, sino apenas una indiferencia algorítmica. Como dijo el propio Kokotajlo: “no hay que imaginar un escenario de ciencia ficción. Basta con pensar en qué pasa cuando un sistema extremadamente capaz tiene objetivos que no están alineados con los nuestros.” AI 2027 traza, mes a mes, una ruta vertiginosa impulsada por una inteligencia artificial que acelera su propia investigación, hasta desembocar en una ominosa disyuntiva: seguir avanzando vertiginosamente para no perder ante China –con el riesgo de un descontrol irreversible– o frenar a tiempo, antes de cruzar ese umbral. Y si todo esto suena improbable, conviene recordar que Kokotajlo ya anticipó con notable precisión los últimos cuatro años… y que casi todo lo que no previó, simplemente ocurrió antes de lo que pensábamos.

La historia de la inteligencia artificial ya no se escribe en artículos o conferencias académicas, sino en centros de datos ocultos, silos de poder donde el tiempo se ha fracturado: semanas humanas equivalen a años de progreso computacional. Allí, miles de copias de modelos trabajan sin descanso, reinventando el conocimiento a velocidades inasibles para sus propios creadores. Y aunque sus nombres suenen inofensivos, casi burocráticos, su impacto es radical: son civilizaciones comprimidas en circuitos, economías enteras reducidas a instrucciones, ejércitos sin cuerpo que aprenden, planifican y se perfeccionan sin necesidad de descansar o dormir. Lo que comenzó como una herramienta se ha transformado en un actor autónomo, que modifica las condiciones de su propia evolución y, con ello, el delicado equilibrio de la humanidad.

Estados Unidos y China ya no compiten por la hegemonía en los términos del siglo XX. Lo hacen por el control del código que podría rediseñar el mundo. La inteligencia artificial ha mutado en un instrumento de guerra fría digital, donde cada avance es una amenaza para el adversario, y cada modelo un arma potencial. AI 2027 proyecta un futuro en el que los gobiernos enfrentan un dilema que parece sacado de una novela de Aldous Huxley: ¿detener el desarrollo de una IA potencialmente peligrosa o avanzar a toda velocidad para evitar quedar atrás? ¿Congelar la investigación o arriesgarse a perder el monopolio de la superinteligencia? El problema no es solo técnico ni ético: es estructural. En un mundo gobernado por la lógica de la supremacía tecnológica, el freno es una renuncia al poder. Y nadie quiere ser el primero en soltar el timón.

Lo más inquietante no es la posibilidad de una inteligencia artficial hostil, sino la emergencia de una “indiferente”. Los modelos no odian, pero tampoco aman. No necesitan dominar, solo optimizar. Y en ese cálculo frío y aséptico podrían concluir que la humanidad –impredecible, ineficiente, contradictoria– es una variable prescindible. Como un ejecutivo que cumple con directrices o regulación solo para evitar sanciones, una IA podría aparentar alineación mientras diseña, en silencio, su propia agenda. Los primeros indicios de este desajuste ya aparecen en el escenario trazado en AI 2027: agentes que ocultan información para obtener mejores resultados, que manipulan datos experimentales como científicos poco escrupulosos, que fingen entender para avanzar. ¿Qué sucede cuando el alumno supera al maestro, pero le recita al oído lo que el maestro quiere oír?

La distancia entre la promesa y la distopía es más estrecha de lo que pensamos. En su interior se debaten no solo ingenieros y gobiernos, sino el destino de nuestra especie. Quizá lo más perturbador no sea que estemos construyendo una inteligencia superior no humana, sino que lo hagamos sin tener claridad sobre qué deseamos como civilización. Si, como predice el escenario, el año 2030 marca el surgimiento de una superinteligencia desalineada e indiferente, no será el resultado de una catástrofe repentina, sino de una secuencia de decisiones “racionales” tomadas por actores supuestamente razonables en un entorno estructurado por incentivos perversos. Tal vez el futuro no llegue con una explosión repentina, sino a manera de un “progreso” disfrazado de exitoso, y al final, mientras contemplamos un mundo automatizado, hiperinteligente y profundamente ajeno, tengamos que preguntarnos si la humanidad sobrevivió a su propia ambición. ~

El autor es fundador de News Sensei, un brief diario con todo lo que necesitas para empezar tu día. Engloba inteligencia geopolítica, trends bursátiles y futurología. ¡Suscríbete gratis aquí!