Este artículo forma parte del Free Speech Project (Proyecto Libertad de Expresión), una colaboración entre Future Tense y el Tech, Law, & Security Program del Washington College of Law de la American University, en el cual se analiza la forma en que la tecnología está influyendo sobre lo que pensamos acerca de la expresión.

En 2016, Facebook censuró una de las imágenes más icónicas del mundo, la histórica fotografía de la niña de 9 años Kim Phúc, quien corría desnuda mientras huía de un ataque durante la guerra de Vietnam. Este acto de censura desató indignación global. Finalmente, la empresa dio marcha atrás en su decisión y se disculpó por eliminar la imagen de su plataforma.

Sin embargo, parece que Facebook no aprendió la lección de ese evento. Recientemente, los nigerianos se convirtieron en las víctimas de las demasiado agresivas prácticas de moderación de contenido de Facebook.

El 4 de octubre, apareció en línea un video que mostraba a miembros del Escuadrón Federal Especial Antirrobo –una unidad táctica de las fuerzas policiacas de Nigeria, también conocida como F-SARS o SARS–, sacar a rastras dos cuerpos inertes de un hotel, para luego dispararle a uno de ellos. El video detonó protestas en línea y presenciales, en un movimiento que empezó a identificarse con el hashtag #EndSARS. En Twitter, un grupo de feministas reunió apoyo y donaciones financieras para los manifestantes. A pesar de los obstáculos impuestos por el gobierno de Nigeria, el grupo y otros participantes crearon una estructura que apoyó una de las protestas más exitosas y orgánicas que el país haya visto. Por su parte, el gobierno de Nigeria respondió con balas y suscitó lo que ahora se conoce como la #LekkiMassacre.

El 20 de octubre, manifestantes pacíficos se congregaron en la caseta de peaje de Lekki, en la ciudad capital de Lagos, tal y como lo habían hecho en semanas previas. A la 1 de la tarde, aludiendo a brotes de violencia en otras partes de la ciudad, el gobierno de Lagos decretó un toque de queda que iniciaría ese mismo día a las 4 de la tarde. Posteriormente, las autoridades dieron marcha atrás y movieron el inicio de la medida a las 9 de la noche, acción que anunciaron a las 8:08 p.m. a través de su cuenta oficial de Twitter. Antes de que los manifestantes pudieran cumplir con la orden, en Twitter comenzaron a circular rumores –rápidamente confirmados– en cuanto a que empleados del gobierno estaban retirando cámaras y apagando las luces alrededor del área de la protesta. A las 6:50 p.m., aproximadamente, personal militar abrió fuego contra los manifestantes, mientras muchos de ellos cantaban el himno nacional nigeriano. Aunque el número de víctimas todavía se desconoce, Amnistía Internacional Nigeria declaró que por lo menos 12 manifestantes fueron asesinados y otros más resultaron heridos. Un testigo presencial reportó que, después de los disparos, el ejército retiró por lo menos 15 cuerpos. Al 27 de octubre, una semana después de los hechos, ni el gobierno estatal de Lagos ni el gobierno federal de Nigeria, habían podido confirmar el número de víctimas.

Mientras el tiroteo tenía lugar, una imagen histórica y simbólica emergió para movilizar a la gente dentro y fuera de Nigeria: una bandera nigeriana bañada en la sangre de algunos de los manifestantes heridos por el ejército. Rápidamente, la bandera sangrienta y otras imágenes alarmantes llegaron a Facebook e Instagram, las cuales de inmediato las clasificaron como información falsa.

Facebook just flagged my post as fake.

— Fragile Dogubo (@fragiledogubo) October 21, 2020

Who is fact-checking internet posts? The truth won't be shut down #EndSARS pic.twitter.com/fa9asI2fO0

El problema parecía ser que los sistemas automatizados de las redes sociales confundían el SARS del hashtag con las iniciales del síndrome respiratorio agudo severo, el precursor de la covid-19. En sus intentos de bloquear la desinformación sobre la pandemia, las plataformas casi les roban a los nigerianos un momento crucial en su historia, además de que ayudaron a la labor de deslegitimar la información sobre la masacre que llevaba a cabo el gobierno nigeriano. Por ejemplo, la cuenta oficial del ejército de Nigeria tuiteó repetidamente que el tiroteo en el peaje de Lekki era una “noticia falsa”; incluso estampó esta frase sobre algunos encabezados.

Posteriormente Instagram se disculpó, diciendo: “nuestros sistemas estuvieron identificando contenido a favor de #EndSARS incorrectamente como falso. Lo sentimos profundamente. El problema ya ha sido resuelto y nos disculpamos por decepcionar a nuestra comunidad en tales momentos de necesidad”. Facebook, que es dueño de Instagram, utilizó un lenguaje casi idéntico en declaraciones a los medios de comunicación que cubrieron la censura.

Me comuniqué con Facebook para averiguar qué había sucedido. La jefa de comunicaciones de la empresa para África subsahariana, Kezia Anim-Addo, confirmó que el error de etiquetado se debió a un sistema automatizado. En un correo electrónico, me dijo:

En nuestros esfuerzos por abordar la desinformación, una vez que un verificador externo de información marca una publicación como falsa, podemos usar la tecnología para encontrar duplicados de esa publicación, de modo que si alguien ve una coincidencia exacta de la publicación desacreditada, también habrá una etiqueta de advertencia de que esta se ha marcado como falsa.

En esta situación, hubo una publicación con una imagen alterada sobre el virus del SARS que fue desacreditada por un verificador externo de información.

La imagen falsa original se indentificó como desacreditada y luego nuestros sistemas comenzaron a desplegarse para ligarla automáticamente con otras imágenes.

Se produjo un error técnico del sistema, en el que las imágenes manipuladas se conectaron a otra imagen diferente, que como consecuencia comenzó a ser catalogada incorrectamente como desacreditada. Esto generó una cadena en la que se extraían más imágenes que continuaban emparejándose como desacreditadas.

Esta es la razón por la que dicho error en el sistema identificó accidentalmente algunas publicaciones de #EndSARS como información falsa.

Le pregunté qué acciones podría tomar Facebook para asegurarse de que esto no vuelva a suceder en un país africano, pero no respondió directamente a la pregunta.

Esa falta de respuestas concretas es especialmente preocupante en esta situación. Hay una gran cantidad de cosas que desconocemos sobre las prácticas de moderación de contenido de Facebook, sobre todo en los países africanos. Por ejemplo, ¿cuántos moderadores de contenido se dedican a la región africana en general y a Nigeria en particular? ¿Cómo trabajan estos moderadores junto con los verificadores de información locales y en qué información basan sus acciones? ¿Cuándo se incorporan las decisiones de humanos a los sistemas de revisión automatizados? Además, más allá de Nigeria, ¿qué tan inclusivos y representativos son los moderadores con respecto al idioma, las subregiones, etc.? Por ejemplo, ¿qué impacto ha tenido el equipo de Facebook en Nairobi hasta ahora? Facebook ahora planea establecer una oficina local en Lagos: ¿qué papel jugarán esta y otras oficinas regionales en las políticas de moderación de contenido? Más allá de las ventas, las asociaciones y las comunicaciones, ¿qué funciones políticas específicas desempeñará la oficina de Lagos?

Al igual que en el caso de la imagen de “La niña del napalm”, el etiquetado de Facebook respecto a las imágenes #EndSARS ha demostrado una vez más que la falta de contexto siempre será un desafío para sus políticas de moderación de contenido. Las empresas de redes sociales no pueden seguir ignorando su responsabilidad de proteger los derechos humanos.

En adelante, Facebook debe reevaluar su excesiva dependencia en la categorización de contenido automatizada, especialmente en la región africana, donde todavía es más probable que sus sistemas de por sí defectuosos pasen por alto contextos importantes. Para Facebook puede ser útil diseñar sistemas de alerta para países africanos donde se categoricen y prioricen los eventos que aumentan los niveles de amenaza para el público; de haber estado alguien observando las protestas de cerca, podría haberse dado cuenta de que el hashtag #EndSARS podía confundir a los sistemas destinados a detectar información errónea sobre el coronavirus. Para ser más útil y eficaz con sus políticas de regulación de contenido, Facebook también debe invertir más en los idiomas africanos locales y en una fuerza laboral cualificada. Esto nos lleva de vuelta a las oficinas de la red social en Nairobi y Lagos: ¿qué papel están desempeñando en la moderación del contenido? ¿Qué poder tienen los moderadores para señalarle cosas al personal superior?

El principal obstáculo de la moderación de contenido no es tanto la falta de soluciones, sino la continua complacencia de las plataformas de redes sociales, que una y otra vez utilizan las disculpas como armas en lugar de tomar medidas activas para mitigar los daños que se llevan a cabo en línea, especialmente fuera de las democracias desarrolladas. La prepotencia y la indiferencia de Facebook son particularmente insultantes, pues Nigeria es el hogar de la mayoría de los usuarios de la plataforma en África. Facebook debe dejar de verse a sí misma como una empresa estadounidense y asumir verdaderamente su papel como empresa globalmente responsable. Si Nigeria y, por extensión, otros países africanos son lo suficientemente buenos como para generar ganancias, también son lo suficientemente buenos para que Facebook asuma cierta responsabilidad con respecto al poder que tiene en la región.

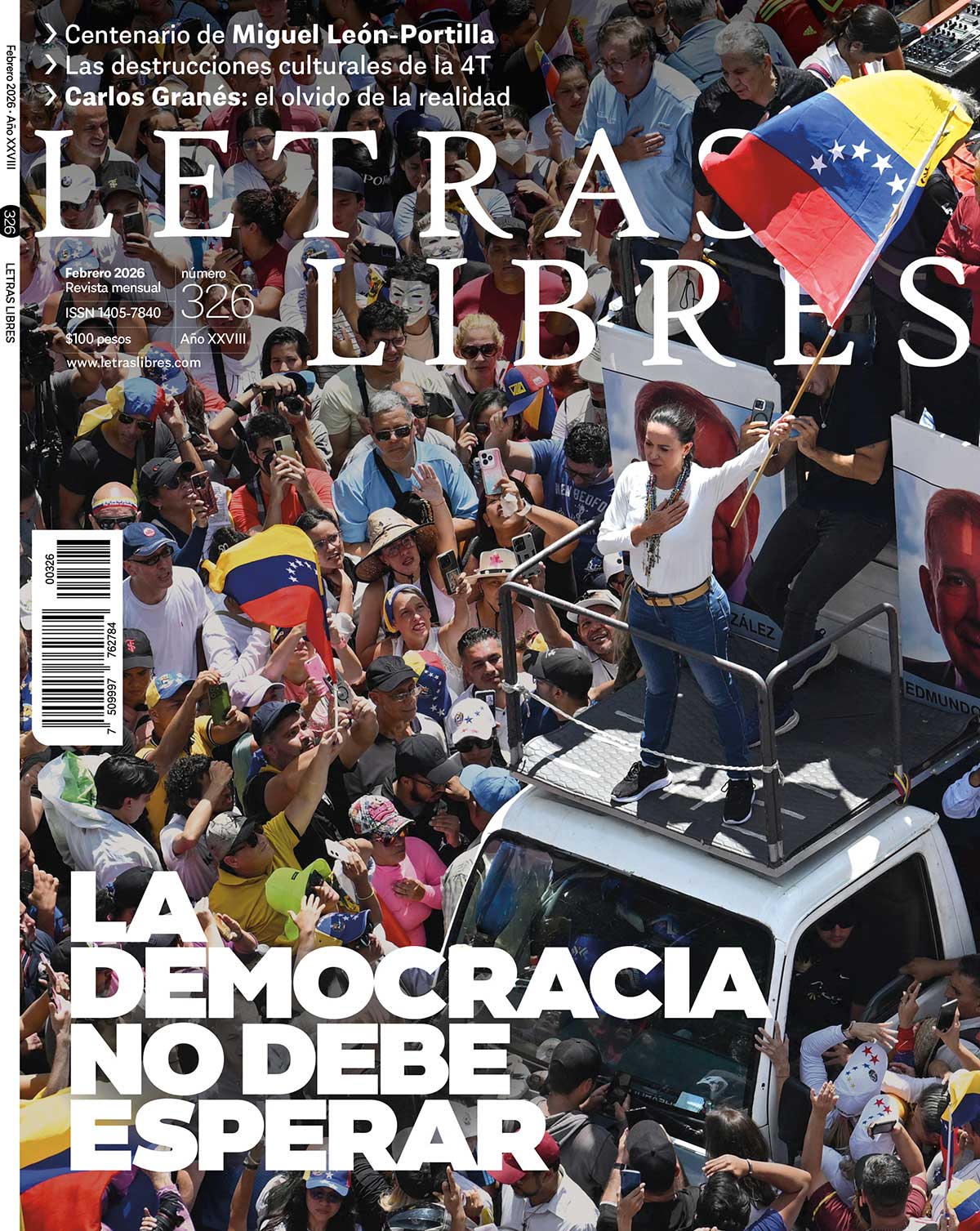

Este artículo es publicado gracias a la colaboración de Letras Libres con Future Tense, un proyecto de Slate, New America, y Arizona State University.

es investigador doctoral en el Centre for Human Rights en la University of Pretoria. También trabaja como investigador en la Expression, Information and Digital Rights Unit en el mismo centro.