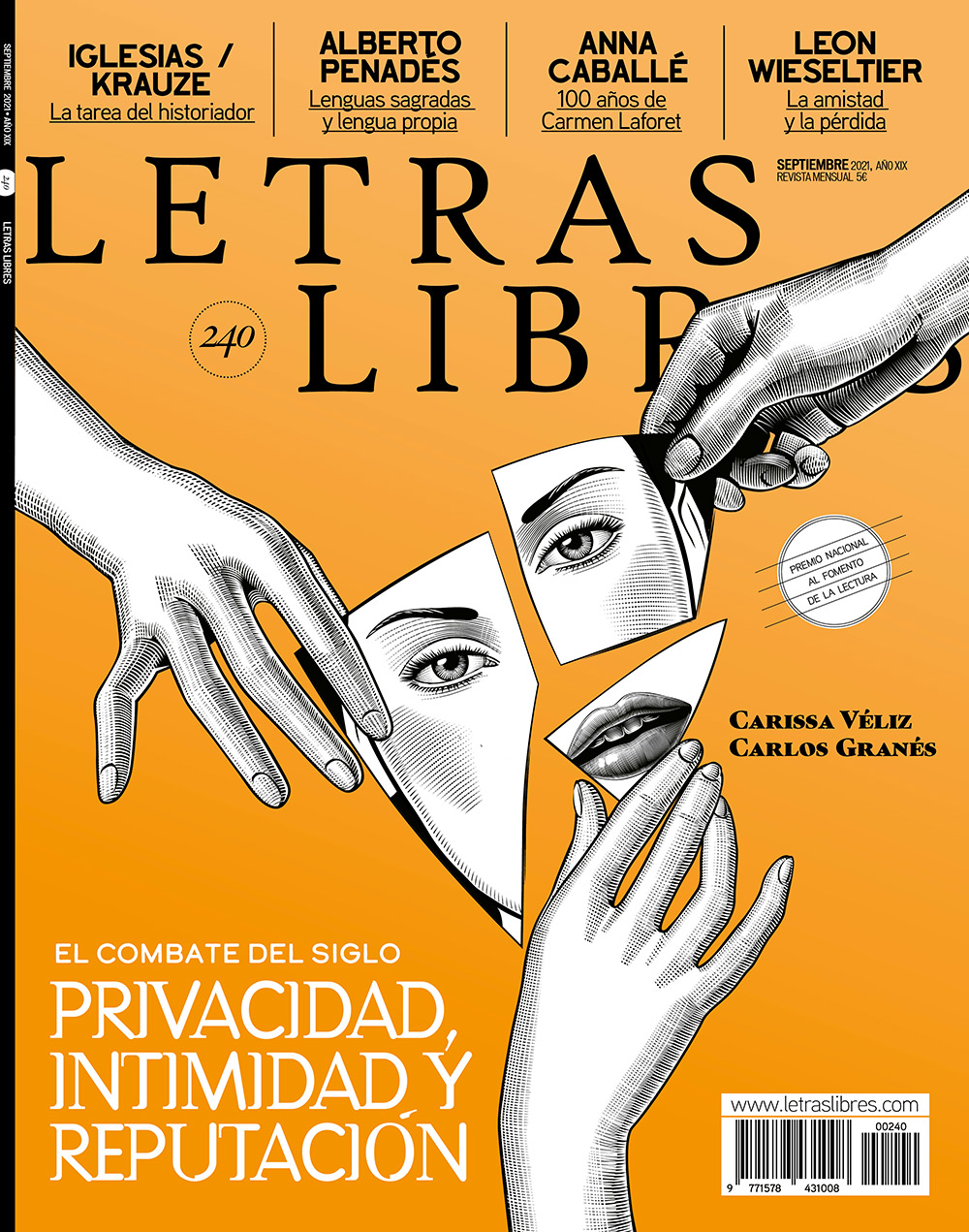

En Privacidad es poder. Datos, vigilancia y libertad en la era digital, que acaba de publicar la editorial Debate, Carissa Véliz, profesora en la Facultad de Filosofía y el Instituto para la Ética en Inteligencia Artificial de la Universidad de Oxford, reivindica la privacidad y la soberanía digital de los individuos frente a la economía de la atención y el capitalismo de vigilancia de las grandes plataformas tecnológicas.

Hay mucha gente que piensa que nuestro móvil “nos escucha”, porque justo cuando hablamos de un producto nos aparece un anuncio sobre él. Pero muchos expertos en privacidad dicen que a estas empresas no les hace falta escucharnos para saberlo todo de nosotros.

El problema es que no nos damos cuenta de cuántos datos estamos cediendo. Y cuánto se puede inferir de esos datos. Conozco gente que me dice eso de que les salen anuncios de casas después de hablar con alguien sobre cambiarse de casa, por ejemplo. En esas ocasiones la persona había hecho búsquedas previas y es probable que sea una información que los anunciantes han inferido. Dicho lo cual, conozco un par de casos de gente fiable, por ejemplo un abogado que se dedica a la protección de datos. Tuvo una conversación con su hija en la que mencionó un término muy particular, cómo llamar a un perro. Nunca había hecho una búsqueda de ello antes ni hablado del concepto. Y sin embargo le salió un anuncio con un término parecido. Eso me hace dudar. Y ahí está el problema. Que no te puedo garantizar cómo se usan esos datos. Una aplicación del móvil te pide acceso a tus datos y te promete que no los usa, pero no hay ninguna policía que vigile que eso es así.

Una cosa que queda clara en su libro es que el llamado capitalismo de vigilancia, es decir, las plataformas tecnológicas que viven de la extracción y comercialización de datos privados, vive exclusivamente de la publicidad.

Sabemos que damos nuestros datos a cambio de publicidad, pero es un conocimiento muy abstracto. Si te dicen “vamos a usar tus datos para ofrecerte publicidad de lo que te gusta”, piensas que no está mal. Pero no sabes lo que hay detrás, los data brokers, cómo funcionan, qué consecuencias tienen para tu vida y la sociedad.

Hemos tardado mucho en darnos cuenta de que los servicios de Google no son gratis. En el libro cuenta cómo la empresa descubrió su modelo de negocio.

En 2001, Google tenía mucho éxito pero no habían encontrado una manera de ganar dinero. Tenían muchos inversores impacientes y estaban en una situación desesperada. Y querían extender el negocio, no querían ser como Wikipedia o una plataforma solo académica o una ONG. No se les ocurrió otra manera de financiarse que usar los datos de sus usuarios para ofrecerles publicidad personalizada. En el libro cuento cómo eran conscientes de los problemas éticos que eso conllevaba. En 1998, Sergey Brin y Larry Page escribieron un paper en el que criticaban otros buscadores y explicaban que si un buscador ofrece anuncios existe la tentación de traicionar a los usuarios, porque al final trabajas para tus clientes. Fueron inteligentes porque decidieron mantener su plan en secreto. No anunciaron nada, en parte para no asustar a los usuarios ni atraer la atención de los gobiernos. Pero también porque de verdad creían que no estaban haciendo nada malo con esos datos. Sí sabían que había diferentes intereses y problemas pero no eran conscientes de lo peligroso que podía llegar a ser.

Se suele decir que cedemos nuestra privacidad a cambio de un producto gratis o de mayor seguridad. Pero en el libro dice que es un falso dilema: la pérdida de privacidad no nos garantizó mayor seguridad contra el terrorismo, y los datos que tienen Google o Facebook sobre nosotros no son esenciales para el funcionamiento de sus productos.

Sí, es una falsa dicotomía para convencernos de que tenemos que ceder nuestros datos privados, y además para convencernos de que somos agentes conscientes de lo que hacemos, que es un trato justo. Pero en realidad cuando se nos contó esta historia el trato ya estaba hecho. Y luego ya no nos podíamos salir, porque es muy difícil dejar Facebook o Google. Y aunque lo dejes siguen recogiendo tus datos. Y en el sentido individual, es un trato muy injusto. Tú con tus datos personales no puedes hacer mucho. No te sirven de nada y si los vendieras ganarías algo así como doce céntimos al año. Pero ellos, al tener miles de millones de datos, pueden hacer mucho. Es una relación muy desigual y asimétrica.

La mayoría de las veces los datos son para financiar a la empresa y no para mejorar el producto. Para mejorar el producto se utilizan muchos menos datos y siempre se pueden borrar o tratar de una manera más segura.

Lo mismo pasa con los gobiernos. En principio se puede hacer una lectura más generosa. Tras el 11s, el gobierno de EEUU sí creía que al tener más datos iba a ser capaz de prevenir ataques terroristas. Resulta que no fue así. El terrorismo es más difícil de analizar, no es como los datos de los hábitos de consumo de los individuos. Y para eso es bueno el Big Data, para cuando tienes muchísimos datos. Pero tener tantos datos personales mal cuidados es un riesgo gigantesco para la seguridad nacional.

Un ejemplo reciente es el caso Pegasus. Se produjo una filtración de datos con 50.000 nombres de individuos que se cree que eran los objetivos de un programa llamado Pegasus. Lo produce una empresa de vigilancia israelí llamada nso Group. Ese programa se vende, en teoría, a gobiernos legítimos y democráticos para vigilar a criminales y demás. En la práctica se está viendo cada vez más que estas herramientas no solo se venden a gobiernos muy cuestionables como Arabia Saudí sino que acaban en manos de delincuentes directamente. En México los tienen los cárteles.

El software de Pegasus es peligroso porque no necesita acceder a tu teléfono físicamente para hackearte, solo necesita mandarte un mensaje o incluso hacerte una llamada que no contestes. Y con eso tiene total acceso a tu teléfono, a tus mensajes de WhatsApp, incluso a los mensajes encriptados de Signal. Puede grabar tus conversaciones, saber tu ubicación. Y hay evidencia incluso de que tiene que ver con el asesinato de al menos dos periodistas: uno en México y otro en Turquía, Jamal Khashoggi.

Los periodistas necesitan privacidad para hacer su trabajo. Si no tienen privacidad no pueden mantener a salvo sus fuentes, y si sus fuentes saben que no van a estar a salvo no van a querer colaborar. Y el propio periodista, si no está a salvo, tampoco querrá arriesgarse. Sin periodismo no puede haber democracia. Nos estamos cargando la democracia sin darnos cuenta a través de estas violaciones de privacidad.

Ahora por ejemplo WhatsApp ha demandado a NSO Group por haber usado Pegasus para hackear el WhatsApp de varios activistas. Y es una buena noticia, pero lo que olvidamos es que empresas como WhatsApp, que pertenece a Facebook, son cómplices de la normalización de la vigilancia.

A menudo pensamos en la privacidad frente a la interferencia de los gobiernos. En nuestra cultura política parece que nos molesta más la invasión estatal que la de empresas privadas.

Hay un equilibrio sano que hay que defender entre la industria, lo público y la ciudadanía. Y cuando esos tres elementos se unen demasiado aparece el riesgo de los Estados totalitarios, como fue el comunismo en Rusia o la China actual.

Hubo un juicio en Estados Unidos en el que se determinó que el gobierno no podía acceder a los datos de los ciudadanos cuando habían cometido algún crimen. Así que lo que hizo el gobierno fue decir: “Bueno, entonces los compramos directamente.” Cualquiera puede comprarle datos a los data brokers. El gobierno pudo saltarse la decisión del Tribunal Supremo porque es muy fácil acceder a esos datos por otra vía. Y lo mismo pasa en el Reino Unido o en la UE.

En esta pandemia, tenemos que comunicarnos con plataformas como Zoom o Teams, que tienen problemas de privacidad. Los gobiernos también están usando esas plataformas, dependen de ellas tanto como nosotros. El flujo de datos entre gobierno y empresas es enorme.

¿Cómo respondería a quien dice que le da igual que usen sus datos porque no tiene nada que ocultar? Era una de las tesis de Zuckerberg o de Eric Schmidt, de Google, hace años.

La comodidad no siempre está bien. Demasiada conveniencia nos hace demasiado complacientes. Por ejemplo, es más fácil no hacer ejercicio que hacerlo. Pero al no hacerlo puedes tener una vida más corta o menos buena. De la misma manera, es muy fácil dar nuestros datos cada vez que nos los piden. Cuesta trabajo decir que no. Pero cuando dices que sí todo el rato, te estás arriesgando y al final puede complicarte la vida.

Hace un año hice una encuesta con una compañera y descubrimos que un 92% de la gente ha tenido alguna mala experiencia con la privacidad online. Habían sufrido algún robo de identidad o les había espiado alguna expareja o les habían humillado públicamente en Twitter. La gente se va dando cuenta cada vez más de que sí tiene algo que esconder. Todos tenemos que protegernos porque todos tenemos algo que perder. Igual que proteges tu cartera proteges tu cuenta bancaria para que no te roben el dinero. No es porque hayas hecho algo malo.

Las plataformas tecnológicas han seguido una estrategia de “hechos consumados”. Cuando tuvimos que empezar a protegernos, el daño ya estaba hecho.

Nos vendieron la moto y la compramos. Zuckerberg nos convenció de que la privacidad era una cosa del pasado y le creímos. Y ahora hemos tenido que reaprender el valor de la privacidad a base de golpes. Lo que pasó con Cambridge Analytica o Pegasus es consecuencia de un internet inseguro. ¿Por qué es así? Porque así lo hemos construido. Todavía no hemos aprendido del todo. Cada vez hay más escándalos preocupantes, cada vez está más claro que la vigilancia lleva al control y a la pérdida de libertad y a la erosión de la democracia. ¿A qué estamos esperando para reaccionar?

Dice que la privacidad no es algo individual sino colectivo.

La privacidad no es solo un derecho sino un deber cívico. Una de las estrategias que han usado las empresas tecnológicas para convencernos de su relato es la de “divide y vencerás”. Es decir, la privacidad es algo individual, una preferencia personal, como si a ti te gusta el chocolate en vez de la vainilla. Y no es así. Porque cuando alguien comparte sus datos con Cambridge Analytica, y esa empresa los utiliza para entenderme a mí, que yo nunca quise dar mis datos, y luego para tratar de perfilarme y manipular mi voto, esa preferencia personal se convierte en algo muy colectivo. Es como con el coronavirus. Una cosa es que a ti te parezca bien arriesgarte y contagiarte y otra es que contagies a otros.

Es decir, que la privacidad no es como la propiedad privada.

Cuando vendo mi casa, y es mía y la compré con mi dinero, tengo la autoridad moral y legal para vender o destruir o hacer lo que quiera con esa casa. Pero cuando vendo mis datos, no tengo esa autoridad moral porque mis datos contienen tus datos también. Si vendo mis datos genéticos, estoy vendiendo datos de mis padres, de mis hermanos, de mis futuros hijos o incluso de extraños que son familia lejana. O igual cuando vendo datos de mi ubicación, también vendo los datos de mis vecinos. Casi nunca tus datos personales son solo sobre ti.

Cuando habla de la privacidad también reflexiona sobre la idea de que tenemos que compartirlo todo en internet. Dice que no tenemos que saber todo de todos. Pensaba en las guerras culturales de internet y la cultura de la cancelación.

Es otro relato que nos han vendido las grandes tecnológicas: si no tienes nada que esconder, debes ser lo más transparente posible, y la gente más transparente es la más ética o virtuosa. Y en realidad el liberalismo depende no solamente de que el gobierno no se meta en tu vida si no es necesario, sino de que tampoco lo hagan tus vecinos. Necesitamos una esfera privada en la que puedas seguir tu religión, tus intereses, que no tienes que compartir necesariamente con nadie, sobre todo cuando compartir conlleva muchos conflictos innecesarios.

También parece que hay un moralismo o puritanismo detrás. Por ejemplo, en el caso de Ashley Madison: el hackeo de miles de cuentas de la web de citas, que desveló adulterios.

Nos aterra que se nos juzgue. Cualquier cosa que digamos o hagamos se usará en nuestra contra, y eso quiere decir que no podemos hablar libremente. Está afectando a las relaciones sociales, a las amistades, pero también a las relaciones entre profesores y estudiantes. Es un moralismo y puritanismo extremo en el que todo el mundo tiene que ser perfecto. Pero es imposible ser perfecto. Siempre habrá alguien que crea que haces algo mal. Algo que me encuentro a menudo es la crítica a las madres en redes. Si estás mucho con tus hijos, se te culpa. Si estás poco, también. No hay manera de ser buena madre. Alguien siempre te criticará.

La esfera pública se vuelve muy peligrosa para algunos tipos de personas. No es que la crítica se distribuya de una manera igualitaria, es que además las minorías reciben la mayoría de estas críticas extremas.

Las redes y las plataformas construyen tu identidad virtual a partir de tus datos y es muy difícil refutarla o cuestionarla. ¿Estamos perdiendo espontaneidad?

Esa identidad muchas veces puede ser falsa. Imagina que hay otra persona que se llama igual que tú que es fumadora, por ejemplo. Sale en una foto fumando y eso te afecta: vas a alquilar un piso y el dueño busca tu nombre en internet y te ve fumando y ni siquiera te enseña el piso. Pero no eres tú, tú no fumas. Hay un caso brutal de robo de identidad, el de Ramona María Timaru. Se pasó años de juicios por toda España defendiéndose, perdiendo miles de euros y con ansiolíticos.

Critica el determinismo tecnológico de las plataformas. Dice que “no hay ninguna tecnología inevitable”.

Es un argumento que sirve para acabar con el debate. Cuando uno se preocupa por una tecnología particular, algunos entusiastas de la tecnología responden que esto es el progreso y punto. Y eso no es así. La tecnología no es como la evolución. Nosotros no tenemos mucho control sobre algunas mutaciones que hacen los virus, que suceden en nuestro propio organismo. Pero la tecnología la creamos nosotros. Por lo tanto, podemos decidir hacia dónde va y hacia dónde no va. Hay ejemplos históricos de tecnologías que pudieron ser y no fueron. Hubo un momento en que los coches eléctricos eran más comunes que los de petróleo y cometimos el error de escoger estos últimos porque encontramos reservas petrolíferas en Estados Unidos y Henry Ford desarrolló modelos muy baratos. Pero podría haber sido de otra manera. También hay otras tecnologías que decidimos no desarrollar porque pueden ser demasiado peligrosas, o porque son demasiado invasivas. Doy el ejemplo de Google Glass. La mayoría de la gente pensaba que era demasiado: entrar a un bar y que un tío cualquiera te pudiera sacar un vídeo sin tu consentimiento.

Lo que me preocupa es que nos han ido poco a poco acostumbrando a ese tipo de invasión. Google y Facebook son muy perseverantes y lo siguen intentando. Creo que a veces su argumento es convincente porque es verdad que la tecnología siempre va a avanzar. Pero eso no quiere decir que no podamos parar determinadas tecnologías porque no nos parecen compatibles con la democracia.

En los setenta, la gente de Silicon Valley, de la Universidad de Stanford, tenía otras ideas sobre el progreso tecnológico. Hoy esa idea democrática y antijerárquica de internet se ha perdido.

Había mucho idealismo. Buscaban que todo el mundo tuviera acceso a toda la información pero también que pudiera contribuir a ella. Había muchos elementos positivos. Pero al final sucedió lo que pasó con Facebook, por ejemplo: que prosperaron empresas que no podrían haber existido quince o veinte años antes. Pudieron nacer porque hubo una serie de avances tecnológicos, como la nube, que las ayudaron. Sin esos avances, no habrían podido obtener el capital que obtuvieron. Y eso hizo que chavales de veinte años tuvieran un poder alucinante. A un chaval de diecinueve años, por muy idealista que sea, le ofreces mil millones de dólares y sus lealtades cambian muy rápido.

Propone varias soluciones al final del libro. ¿Por qué cree que hay que acabar con los anuncios personalizados en internet?

Son muy peligrosos. Se pueden utilizar de una forma muy perjudicial para hacer propaganda personal, como ocurrió con Cambridge Analytica. Y las ventajas son muy pocas y se pueden obtener de otras maneras. Cuando hablo con gente de esto me dice: “Pero es que yo no quiero ver anuncios que no me interesen.” Y yo tampoco, no me apetece ver anuncios de coches cuando no estoy pensando en comprarme un coche, pero no necesitamos saber mucho sobre ti para ofrecerte anuncios que te interesan. Si tú buscas online gafas de sol, eso es todo lo que necesita saber una empresa de gafas de sol para ofrecerte su producto. No necesita saber tu orientación sexual, tu tendencia política, dónde vives…

Si volviera a escribir el libro, añadiría una sección sobre cómo la gente que diseñó los mercados de las hipotecas subprime, que causó la crisis de 2008, es la misma gente que diseñó los mercados de subastas de los anuncios personalizados. Ambos mercados pecan de lo mismo, por ejemplo de que son muy opacos. Imagínate que tienes una tienda de zapatos que quiere comprar un anuncio en El País. Hay un intermediario que te dice que te lo vende, en primera plana, durante una semana, y lo van a ver chavales de entre dieciocho y veintitrés años. Pagas un dineral por ese anuncio y luego nunca puedes verificarlo. Si tú no eres el perfil al que apela el anuncio, te mostrarán otro anuncio. Entonces resulta que hay muchísimo fraude. Hay muchos intermediarios que dicen vender anuncios en los mejores sitios, en The Guardian, The New York Times. Y al final es un fraude, nunca los ve nadie. Hay miedo a que se produzca una burbuja de los anuncios online parecida a la burbuja de las subprime en 2008. Cuando la gente se dé cuenta de que ha estado pagando anuncios por nada, en primer lugar porque no son muy efectivos, en segundo lugar porque son muy caros y en tercer lugar porque hay mucho fraude, todo se puede venir abajo.

Cada vez se sabe más sobre ese fraude o la inefectividad de muchos anuncios online. ¿Por qué sigue siendo un mercado tan importante la publicidad en internet?

En primer lugar por la opacidad, la incapacidad de verificar. Por otro lado, porque todo el mundo lo hace. Y si tus competidores lo hacen, tú también debes hacerlo. Y en tercer lugar, Google y Facebook tienen tantos usuarios que es muy atractivo pensar que millones de personas pueden ver tu anuncio. Yo en el libro digo, y me lo han criticado, que mientras que en los anuncios no es muy efectiva la publicidad personalizada, sí es determinante y suficientemente efectiva en política como para preocupar.

La publicidad personalizada sí que es un poco más efectiva que la convencional, pero es que es tan cara que no merece la pena la inversión. El problema con las elecciones, aunque también es muy poco efectiva, es que se ganan o se pierden por unos cuantos cientos o miles de votos. Si puedes identificar a los indecisos que pueden cambiar el sentido de su voto, te puede servir para darle la vuelta a unas elecciones. No son suficientemente efectivos como publicidad pero sí como propaganda.

Se ha hablado mucho de Cambridge Analytica en los últimos años. Pero ese tipo de propaganda a través del microtargeting no es nuevo. Obama hizo lo mismo en sus campañas e incluso empleó a Eric Schmidt de Google en ellas.

Lo que hizo Obama estuvo fatal e inició un tipo de campañas que ha sido muy nocivo. Pero hay una diferencia entre Obama y Cambridge Analytica: por entonces no éramos tan conscientes. Ha sido un proceso paulatino de concienciación. En segundo lugar, Obama no ganó por unos cuantos miles de votos. Trump sí, por unos 70.000 votos en los swing states. En tercer lugar, Cambridge Analytica usó muchos más datos: unos doscientos millones de votantes. Es una escala mayor y con más datos sobre cada individuo. E hizo algo tremendamente poco ético que Obama no hizo: la empresa trató de identificar a la gente que consideraba fácil de persuadir, e intentó convencer a esa gente de no ir a votar, desincentivar el voto. Y eso es ir en contra de la democracia.

Otra de las soluciones que da al final del libro tiene que ver con exigir a las empresas tecnológicas que nos digan qué información tienen de nosotros, y el derecho a retirarla. Recuerda al llamado “derecho al olvido”.

Es escalofriante pensar que hay cientos de empresas que tienen tus datos y no sabes cómo los utilizan. Y también hay cientos de algoritmos decidiendo sobre ti, sobre si darte un apartamento o un empleo o un préstamo. Y no sabemos nada. Una cuestión importante es tener la capacidad de borrar datos. Históricamente, el olvido ha jugado un papel fundamental en las sociedades y para los individuos también. Era algo que no teníamos que tratar de conseguir, llegaba naturalmente. Porque nuestra mente es limitada y se nos olvidaban cosas, o porque recoger datos era muy caro y demandaba mucho esfuerzo. Tenías que escoger qué recopilabas porque no podías recogerlo todo. Y también los datos que recogíamos se borraban con el tiempo. El papel, por ejemplo, sin ácido se desintegraba. Y había incendios, inundaciones. Había una ola natural de olvidos que acababa siendo muy sana para la sociedad. Porque una sociedad que no olvida nunca tiende a ser una sociedad muy impía.

La economía de los datos ha modificado totalmente eso. Ahora el modo predeterminado o default es recopilar todo y guardarlo para siempre. Porque recordar todo es más barato que seleccionar qué recordar y qué borrar. Esto está cambiando las relaciones de poder de la sociedad. Hay una tendencia al vigilantismo y el moralismo: no se puede cometer ningún error, y si se comete, nunca se olvida. Hay que reintroducir el olvido en un contexto en el que ya no es lo normal o natural. Una manera de hacer eso es dar herramientas a la gente para que puedan borrar sus datos. Esto ya está contemplado en la gdpr [el reglamento general de protección de datos de la ue], pero las empresas todavía no han elaborado herramientas con las que sea fácil eliminar tus datos. Y sobre todo verificar que tus datos estén realmente borrados. ~

Ricardo Dudda (Madrid, 1992) es periodista y miembro de la redacción de Letras Libres. Es autor de 'Mi padre alemán' (Libros del Asteroide, 2023).