Permítame el sufrido lector empezar con una archimanida referencia al preámbulo del Manifiesto comunista de Marx y Engels: hoy un fantasma recorre no solo Europa sino todo el mundo, y no es el comunismo sino la Inteligencia Artificial (IA) y sus peligros. No hay día en que algún medio de comunicación escrito o audiovisual no le preste una atención inusitada –incluyendo The Economist,que ya le ha dedicado seis portadas–, y no tanto a sus posibilidades y beneficios para el desarrollo social y económico como a sus peligros y riesgos.

También hemos visto el escándalo de que un prestigioso premio fotográfico se fuera a otorgar no a una fotografía auténtica sino a una creada por IA, o que las noticias dan cuenta diaria de empresas que sustituyen a sus trabajadores humanos por sistemas de IA.

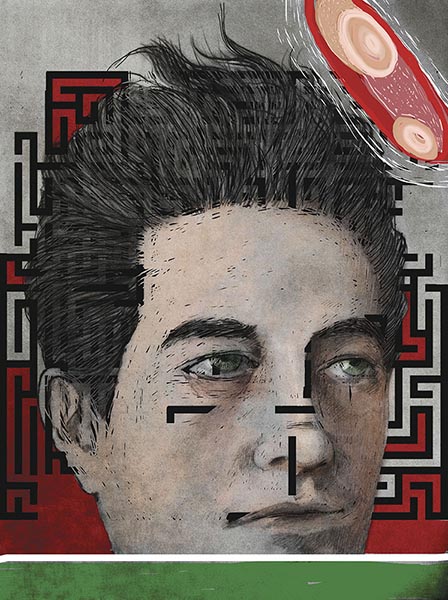

La AI está transitando rápidamente desde la utopía a la distopía y llama la atención que en un mundo tan complejo hayan brotado como setas expertos en un asunto como este, de gran dificultad tecnológica. Xabi Uribe-Etxebarria, uno de los mayores expertos españoles en la materia, hacía un certero diagnóstico en una entrevista de hace unos años: “en el mundo de la Inteligencia Artificial hay mucho cantamañanas”.1 El paso del tiempo no ha hecho más que confirmarlo.

Probablemente el entusiasmo e interés generalizado en la opinión pública por la IA se deba a la irrupción de ChatGPT, algo que no supone en sí mismo una gran novedad pero que sí ha permitido por primera vez al gran público experimentar, ver y tocar la IA.

El apocalipsis que viene

A riesgo de ser encuadrado en el ejército de cantamañanas, diré que el fenómeno requiere un comentario tranquilo y sosegado. Vayamos por partes: todo cambio de era, y la digitalización lo es, desata miedos y recelos, movidos una veces por la ignorancia y otras por los daños que ocasionan las innovaciones en quien vive anclado en la era anterior o no tiene posibilidad de prescindir de ella. Hemos visto cómo la irrupción de determinados modelos de negocio de la mano de las plataformas digitales ha suscitado la reacción de los afectados. Un ejemplo paradigmático ha sido la movilización de los taxistas, nuestros luditas más castizos, que tras mucho esfuerzo han llegado a entender que es mejor adaptarse que desaparecer y que es mejor influir en la elaboración de las reglas que bloquear las calles. A la postre, todos hemos entendido que en la economía digitalizada hay sitios para los nuevos y los antiguos, también para los taxistas.

No han sido tampoco ajenos a este movimiento de resistencia a la digitalización los luditas light por antonomasia, los sindicatos, que, más sofisticados, hacen proclamación de su fe en la tecnología y la digitalización para a continuación y por la puerta de atrás promover todo tipo de obstáculos normativos al desarrollo de la economía digital, tal y como ha sucedido en la regulación del teletrabajo o de los riders. Incluso hemos visto cómo en las últimas modificaciones legislativas en materia laboral y en el último acuerdo social los sindicatos han introducido cláusulas o disposiciones tendentes a limitar el uso de la IA.

Hasta aquí nada nuevo, nada que no fuera previsible ni que no hubiéramos visto antes.

Lo que no esperábamos con la irrupción de la IA era la aparición de un grupo de luditas exquisitos: expertos en IA o pensadores innovadores del siglo XXI, grupo heterogéneo muy lejos de ser cantamañanas, que desde el profundo conocimiento técnico o desde la atalaya de la filosofía política nos alertan de las consecuencias negativas que para nuestra sociedad tiene la IA, que ellos han contribuido a desarrollar o difundir, y la conveniencia de plantearse seriamente su desarrollo o incluso establecer una moratoria de varios años. Es como si Thomas Newcomen o James Watt hubieran alertado en su momento de los grandes peligros de la industrialización y hubieran pedido la moratoria en el desarrollo de la máquina de vapor.

Así, en los últimos días hemos sabido que uno de los directivos de Google, Geoffrey Hinton, ni más ni menos que uno de los creadores de las redes neuronales, ha alertado de los peligros futuros del desarrollo de la IA, anunciando que abandona la empresa. Para Hinton, la IA “ puede llevarnos al fin de la civilización en cuestión de años”, y cree que va a superar las capacidades del cerebro humano en un plazo corto de entre cinco y veinte años. Sus palabras han tenido una repercusión extraordinaria en la opinión pública y publicada porque concretan estos miedos difusos que ya existían y los pone en boca no de un apocalíptico sino de un integrado, en la de un experto, un Pablo de Tarso en plena caída del caballo, un converso, figura que siempre tiene, como la de los pesimistas, mucho prestigio intelectual.

Por su parte, Yuval Noah Harari, desde su atalaya telavivi y la resaca de su prestigio bien ganado pero estirado hasta la saciedad, también nos ha advertido, en The Economist nada menos, de que la IA amenaza la supervivencia de la civilización. Se pregunta Harari: “¿Qué ocurrirá con el curso de la historia cuando la IA se apodere de la cultura y empiece a producir relatos, melodías, leyes y religiones? Las herramientas anteriores, como la imprenta y la radio, ayudaron a difundir las ideas culturales de los humanos, pero nunca crearon ideas culturales propias. La IA es en todo punto diferente. La IA puede crear ideas completamente nuevas, una cultura completamente nueva.”2

Hemos visto también a un grupo de mil expertos pedir una moratoria en el desarrollo de la IA hasta que esté completada su regulación, un grupo que cuenta con nombres tan sonoros como el de Elon Musk o Steve Wozniak. Uno de los fundadores de Openai, a quien pertenece ChatGPT , ha urgido en términos muy dramáticos a una regulación enérgica del desarrollo de la IA.

En resumen, un festín para los morbosos y catastrofistas de toda condición y también para los defensores de la tecnoresistencia.

Más equilibrados, otros pensadores como Kai-Fu Lee, desde la tecnología,3 o Michael Ignatieff,4 se han pronunciado de manera más moderada, alertando de los problemas en materia de datos, transparencia o seguridad o llamando la atención sobre el hecho de que los sistemas de IA se están desarrollando a una velocidad mayor que nuestra capacidad para regularlos.

Definir la IA

La Enciclopedia Británica (que todavía existe online) define el concepto de IA como “la habilidad de una computadora o de un robot controlado por una computadora de realizar tareas normalmente asociadas a seres inteligentes”. Veamos otra definición, menos convencional y más detallada:

La inteligencia artificial (IA) se refiere a la capacidad de las computadoras y los sistemas para realizar tareas que, tradicionalmente, requieren inteligencia humana. La IA se enfoca en el desarrollo de algoritmos y sistemas que pueden aprender y tomar decisiones por sí mismos, basándose en datos y experiencias previas.

En general, existen dos tipos de IA: la IA débil o estrecha y la IA fuerte o general. La IA débil se enfoca en solucionar tareas específicas, como reconocimiento de voz, visión artificial o traducción de idiomas, mientras que la IA fuerte tiene como objetivo replicar la inteligencia humana en todos sus aspectos.

La IA se ha utilizado en una amplia variedad de aplicaciones, incluyendo asistentes virtuales, sistemas de recomendación, detección de fraudes y reconocimiento de patrones en imágenes médicas. La IA también ha sido objeto de controversia, ya que algunos temen que pueda reemplazar trabajos humanos o ser utilizada de manera malintencionada.

Esta descripción de la IA es una autodefinición: es la descripción que nos da ChatGPT, es decir, la IA definida por la IA.

Sigamos con ChatGPTy preguntémosle sobre los peligros de la IA:

La inteligencia artificial (IA) presenta ciertos riesgos y desafíos que deben ser considerados y abordados para garantizar su uso seguro y ético. Algunos de los peligros potenciales de la IA incluyen:

- Desplazamiento de trabajos: A medida que los sistemas de IA y automatización se vuelven más avanzados, es posible que reemplacen algunos trabajos tradicionales, lo que podría llevar a una mayor desigualdad económica.

- Sesgo algorítmico: Los algoritmos de IA se basan en datos y pueden reflejar sesgos y prejuicios involuntarios. Si no se detecta y corrige, esto podría llevar a decisiones discriminatorias e injustas.

- Autonomía no deseada: Si los sistemas de IA se vuelven demasiado avanzados, es posible que tomen decisiones por sí mismos sin la supervisión adecuada, lo que podría tener consecuencias no deseadas.

- Dependencia tecnológica: La creciente dependencia de la IA y la tecnología podría hacer que las personas pierdan habilidades valiosas y se vuelvan menos capaces de tomar decisiones importantes sin la ayuda de la tecnología.

- Uso malintencionado: Al igual que cualquier tecnología, la IA también puede ser utilizada para fines malintencionados, como la manipulación de información o la creación de armas autónomas.

Es importante abordar estos riesgos y desafíos para garantizar que la IA sea segura y beneficiosa para la sociedad en general. Esto puede incluir la regulación gubernamental, la investigación ética y la implementación de sistemas de supervisión y transparencia.

Ninguna sorpresa; en el mar de información sobre el que navega y en el que pesca ChatGPT nada ha sido dicho de los peligros críticos y existenciales de la IA.

Busquemos otra definición más precisa, propuesta por la Unión Europea:

La inteligencia artificial (IA) se refiere a los sistemas que muestran un comportamiento inteligente mediante el análisis de su entorno y la toma de acciones, con cierto grado de autonomía, para lograr objetivos específicos. Los sistemas basados en la IA pueden estar puramente basados en software, actuando en el mundo virtual (por ejemplo, asistentes de voz, software de análisis de imágenes, motores de búsqueda, sistemas de reconocimiento de voz facial y de voz) o la IA se pueden integrar en dispositivos de hardware (por ejemplo, robots avanzados, coches autónomos, drones o aplicaciones de internet de las cosas).

Esta última definición muestra el talento de las instituciones europeas para definir las cosas. Pero ¿cuáles son las características de la IA? Es el mundo de los algoritmos: la IA se basa en algoritmos que extraen resultados de un gran volumen de datos y tiene una velocidad de aprendizaje y entrenamiento superior a la humana. Además, la IA no se degrada y es incansable. Tiene un comportamiento inteligente, cierto grado de autonomía y no solo se refiere al software sino también al hardware, y está directamente relacionada con el desarrollo de la computación cuántica.

Así, tres son los atributos de la IA: conducta inteligente, cierto grado de autonomía y se refiere tanto al software como al hardware.

No es ocioso precisar que lo que en realidad está generando este nivel de debate y alarma es la llamada IA generativa, es decir, aquella que es capaz de aprender de los datos de entrada y patrones, generando contenidos con un cierto grado de novedad frente al sistema informático tradicional en el que nada sale si no entró antes. El sistema es capaz de razonar e introducir información adicional que no se había introducido tal cual.

¿En qué se diferencia la inteligencia artificial de la humana?

Tres son las características de la inteligencia que no puede replicar la IA: el multipropósito, el conocimiento reutilizable y la creatividad e imaginación.

Esto nadie lo discute, la diferencia de criterio radica en que esto es, para unos, simplemente el estado de la cuestión a fecha de hoy, mientras para otros la IA no es ni será nunca jamás inteligencia, es solo una sofisticada combinación de algoritmos, capacidad de procesamiento y grandes bases de datos.

Profundicemos un poco en este dilema de la mano de Ramón López de Mantaras, un gran experto en este tema que ha analizado en detalle la diferencia entre la inteligencia artificial y la humana. Sigue a Allen Newell y Herbert Simon cuando define la inteligencia como un sistema de símbolos físicos que funcionan como fuentes de las acciones inteligentes y que tienen sustrato físico, el cual puede ser biológico o electrónico, neuronas o circuitos, es decir, inteligencia artificial o inteligencia humana.5

La IA, para ser comparable, debería ser de carácter general, como es la inteligencia humana: Deep Blue puede ganar al ajedrez a cualquier ser humano, pero no es IA de carácter general, tampoco lo es ChatGPT.

De ahí surge la sustancial diferencia entre IA fuerte y débil. La fuerte es la general, como la humana, aunque como dice el filósofo Searle, no toda ia general (multitarea) es fuerte. El resto no tiene capacidad de desplazar ni rivalizar con ella. Solo la ia general puede tener los efectos y albergar los peligros que nuestros luditas de última generación atribuyen a la ia.

Y aquí nos encontramos con la búsqueda del Santo Grial: la IA general fuerte.

Hasta ahora no hemos visto más que IA débil y específica, incluyendo la cognitiva, que es la que está detrás de ChatGPT. La duda y el debate no están aquí, sino en si en algún momento la veremos como parecen defenderla nuestros luditas exquisitos.

La inmensa complejidad neuronal del cerebro hace pensar que la singularidad, la superinteligencia artificial, réplica del cerebro que supere a la inteligencia humana, es, como dice López de Mantaras, una predicción con poco fundamento.6

Todavía está vigente la afirmación del filósofo Hubert Dreyfus de que la IA fuerte de tipo general es tan inalcanzable como para los alquimistas del siglo XVII transformar el plomo en oro.

Las carencias de la IA

Para la IA, la barrera infranqueable está en el cuerpo, con su capacidad de actuar con el entorno a través de las experiencias. El cuerpo, y no solo el cerebro, conforma la inteligencia, y sin cuerpo no puede haber inteligencia de tipo general.

Tampoco las máquinas tienen sentido común ni se les puede dotar de él, y sin sentido común no es posible una comprensión profunda del lenguaje ni una interpretación inteligente de lo que capta un sistema de percepción visual o táctil. Estos conocimientos son producto de nuestras vivencias y experiencias como humanos, y dan una generalidad y profundidad inalcanzable para las máquinas, que solo funcionan en entornos restringidos y preparados y no entienden la relación causa-efecto, solo la correlación.

Los sistemas de IA no aprenden como el ser humano, son el olvido catastrófico, no tienen capacidad multipropósito: lo que aprenden en un área no pueden utilizarlo deductivamente en otra.

Concluye López de Mantaras que “por muy inteligentes y generales que llegaran a ser las futuras inteligencias artificiales, siempre serán distintas a la inteligencia humana ya que dependen de los cuerpos en los que están situadas. El desarrollo mental que requiere toda inteligencia compleja depende del entorno. A su vez, estas interacciones dependen del cuerpo. Probablemente las máquinas seguirán procesos de socialización y culturización distintos a los nuestros, por lo que, por muy sofisticadas que lleguen a ser, serán inteligencias distintas a las nuestras. El hecho de ser inteligencias ajenas a la humana –y por lo tanto ajenas a nuestros valores y necesidades– debería hacernos reflexionar sobre las posibles limitaciones éticas al desarrollo de la IA”.7

Por ser más precisos: ¿qué es lo que nunca podrá hacer la IA? Nunca podrá 1) partir de cero y crear algo que no existe; 2) opinar, ser autocrítica; 3) sentir emociones: la IA no puede experimentar emociones como los humanos; 4) pensar de manera abstracta y creativa o improvisar.

No parece que con esta realidad encima de la mesa sea muy racional angustiarse por la capacidad de la IA de desplazar a la humana y poner fin a nuestra civilización. Sería contrario a la experiencia decir que esto nunca podrá suceder, pero no que esto no podrá suceder en un futuro alcanzable.

Los riesgos reales de la IA y su regulación

Parece, por tanto, que no tiene mucho sentido continuar esta discusión sobre el advenimiento del apocalipsis o sobre las prohibiciones definitivas o temporales. Es un ejercicio inútil o melancólico. Centrémonos en aquello que realmente merece la pena. No permitamos que el árbol del apocalipsis tecnológico nos impida ver el bosque de los riesgos reales y abordemos los problemas concretos, no los que todavía no existen y nunca van a existir, sin regodearnos en distopías. Más nos vale enfocarnos en problemas más reales y riesgos más tangibles.

¿Quiere esto decir que el uso de la IA no implica riesgos? ¿Que no hay que regular la IA? Al contrario, esta necesidad es más urgente que nunca porque, como ha dicho Michael Ignatieff, la IA no debería evolucionar mucho más deprisa que nuestra capacidad para regularla.8

Centrémonos pues en la necesidad de abordar una regulación de la IA y los problemas reales de su implementación, que como señala Kai-Fu Lee,9 se resumen en cuatro: transparencia, datos, seguridad e imparcialidad. También en cómo detectar los errores en el diseño, los dilemas éticos y cómo tratar aquellos casos en que, excepcionalmente, deba plantearse la prohibición de su uso, como sucede con las armas totalmente autónomas basadas en la IA.

De lo que estamos hablando aquí, puesto en contexto, es también de modelos de digitalización, ya que la IA es una parte central de la regulación de la economía digital y la digitalización. Nos vamos a encontrar de nuevo con los diferentes modelos de digitalización que tuvimos ocasión de describir en artículos anteriores de Letras Libres y que representan diferentes modelos de sociedad, y lo que es más importante, valores distintos: los valores occidentales defensores de la sociedad abierta y los autoritarios de una China emergente. Si en algo se manifiestan estos valores, es en la manera en que afrontan los dilemas éticos de la digitalización, que están centrados en muy buena parte en la regulación de la IA.

Los modelos regulatorios responden a los bien conocidos esquemas de light touch, regulación intensa y control autoritario. Nadie se sorprenderá al saber que el primero es el modelo anglosajón, sobre todo de un Reino Unido que quiere jugar fuerte en esta industria y atraer inversiones en IA. El segundo corresponde a Europa, en el marco de su estrategia digital. Y el tercero, a China, con una regulación intrusiva que requiere que todos los productos desarrollados por la IA se registren y sean sometidos a un escrutinio por parte del gobierno antes de comercializarse, y siendo sus creadores responsables del contenido, que no puede subvertir el poder del Estado, incitar a la secesión o perturbar el orden económico y social y debe ser conforme a los valores socialistas.

Y nunca debemos olvidar que estos tres modelos, sobre todo el primero y el segundo, implican modelos de sociedad, y que este es el great game del siglo XXI. Esta es la batalla por la hegemonía, la lucha por la supremacía tecnológica, la del desarrollo de la digitalización, pero sobre todo la batalla por el liderazgo en la IA y la computación cuántica. No es exagerado decir, aunque suene ampuloso, que quien domine la IA dominará el mundo.

Merece la pena detenernos algo más en el modelo europeo, que es pionero, el más desarrollado y el que, salvo en China, acabará influyendo a los demás reguladores, de acuerdo con la vocación europea de rule setter digital. Probablemente será la regulación europea el espejo en que se mirarán la mayoría de los países cuando se planteen la necesidad de abordar regulatoriamente la IA. Además, es la regulación más completa y acorde con los principios y valores de la sociedad democrática.

La regulación europea responde a una serie de principios:

1. Supervisión humana: debe ser supervisada por seres humanos, con las medidas de contingencia apropiadas.

2. Robustez y seguridad: los sistemas deben ser “resistentes” a posibles intentos de manipulación o piratería y estar equipados con planes de contingencia.

3. Privacidad y control de datos: la privacidad de los datos de los ciudadanos debe garantizarse durante todo el ciclo de vida de la IA.

4. Transparencia: la IA debe ser transparente, lo que significa ser capaz de reconstruir cómo y por qué se comporta de cierta manera, y aquellos que interactúan con esos sistemas deben saber qué es IA, así como qué personas son responsables de ella.

5. Diversidad, no discriminación y equidad: la IA debe tener en cuenta la diversidad social desde su desarrollo para garantizar que los algoritmos en los que se basa no tengan sesgos discriminatorios directos o indirectos.

6. Bienestar social y ambiental: el desarrollo tecnológico debe tener en cuenta su impacto social y ambiental de una manera que sea sostenible y ecológicamente responsable.

7. Responsabilidad: la IA y sus resultados deben rendir cuentas a los auditores externos e internos.

Bajo estos principios, la regulación europea, recientemente anunciada, aborda la IA a partir de los peligros específicos creados por ella, distinguiendo cuatro niveles de riesgo en las aplicaciones desarrolladas con su uso: riesgo inaceptable, riesgo alto, riesgo limitado y riesgo mínimo, los cuales determinarán un nivel diferente de regulación. Así, en las aplicaciones de alto riesgo se definen obligaciones de un análisis de conformidad con carácter previo a su lanzamiento al mercado y determinadas obligaciones que contempla el proyecto de reglamento.

Descritos los rasgos principales de los modelos regulatorios habrá que recapitular sobre cuáles son los retos fundamentales de la regulación:

1. Nada nuevo bajo el sol: llevamos muchos años regulando la salud o la industria farmacéutica, aunque es exagerada la comparación con la regulación de las centrales nucleares, como se ha hecho recientemente.

2. Es necesario encontrar el equilibrio regulatorio y evitar las tentaciones prohibicionistas o que establezcan moratorias: la regulación de la IA no debe matar su desarrollo ni frenar la innovación.

3. Hay que abordar problemas realmente existentes y no de futuro imperfecto, y entre ellos el más relevante y delicado es el relativo a la compatibilidad con el Reglamento General de Protección de Datos y el uso de los datos. También es necesario garantizar la ciberseguridad y prevenir la desinformación y los deep fakes.

4. Una regulación pragmática de la IA debe centrarse, más que en dirigir su desarrollo y establecer qué es lo que se puede hacer, en aquello que no, y fijar límites que han de respetarse en el ámbito de la IA.

5. No hay algoritmos éticos o no éticos: el objeto de la regulación no pueden ser los algoritmos, el objeto deben ser las personas y las normas que deben seguirse y sobre todo lo que debe evitarse en su diseño y desarrollo.

6. Es evidente el riesgo de los sesgos de todo tipo, especialmente ideológicos o de género, en el desarrollo de la IA, pero evitarlos no puede llevar a la construcción de una IA políticamente correcta que limite el desarrollo de la tecnología ni que impida que sea un cauce que también refleje la pluralidad social.

7. El ceo de Google, Sundar Pichai, ha sugerido crear una agencia internacional poniendo los ejemplos, muy poco afortunados, de la Asociación Internacional de Transporte Aéreo (IATA) o el Instituto de Asuntos Internacionales y Europeos (IIEA). La IA es un fenómeno global y tiene que aspirar a una regulación global, pero la existencia de una división radical de modelo, occidental y oriental, va a hacer esta tarea muy difícil. Durante un tiempo a lo más que podemos aspirar es a que aquellos usos abiertamente peligrosos, por ejemplo, en el desarrollo de determinadas armas, sean objeto de acuerdos internacionales o al menos bilaterales. De nuevo la disuasión mutua en el mundo geopolítico.

8. Es necesario regular el impacto de las consecuencias del desarrollo de la IA en el empleo y en la forma de trabajar, pero desde un equilibrio que no mate la innovación.

9. En algunos casos, los que la ue llama “riesgos inaceptables”, será necesario prohibir la utilización de los sistemas de IA en determinadas áreas, como la de las armas autónomas.

10. No estaría de más empezar a considerar riesgos asociados a la computación cuántica en relación con la seguridad de los datos o la fiabilidad a largo plazo del blockchain.

Si contrastamos estos retos y sus posibles soluciones con los modelos políticos y regulatorios descritos, vemos que el resultado es desigual o, como en los pimientos de Padrón, unos pican y otros no.

Los desafíos éticos

Fuera de esta lista hay que tener en cuenta los desafíos éticos: detrás de los fríos algoritmos hay alma, y como todo alma, es compleja y, a veces, perturbadora.

El problema de la IA no está en el sistema, está en sus diseñadores. Toda esta regulación debe dirigirse a mantener los estándares éticos de nuestra sociedad y sus valores: libertad, igualdad y preservación de la verdad en el mundo de la IA.

Estos problemas de regulación vuelven a centrarnos en lo que es la esencia del problema o, mejor, de la solución: el foco fundamental de toda regulación de la IA debe ser sobre todo la transparencia, la transparencia sobre quién diseña los algoritmos, la transparencia de saber cuándo una noticia o representación digital es auténtica o fake, la transparencia de conocer cuáles son los límites, la transparencia de saber cómo se usan nuestros datos. No es algo novedoso: desde la Revolución francesa, la transparencia ha sido uno de los pilares de la democracia y la sociedad abierta.

Solo así podremos acostumbrar a una sociedad digital y digitalizada de ciudadanos libres e informados a vivir de manera pacífica, responsable y despreocupada, en el mejor sentido, y a no dejarse seducir por los profetas del apocalipsis digital.

Lo ha resumido muy bien Ignatieff: el reto es cómo garantizar la permanencia de la verdad.10

Una vez más, la resolución a los desafíos que desde el punto de vista político y regulatorio plantea la digitalización es la de la permanencia de los valores y principios de la sociedad democrática occidental en los cambios, a veces vertiginosos y radicales, provocados por los avances tecnológicos y sus consecuencias, y de cómo preservar la libertad colectiva e individual y los principios de la sociedad abierta.

Saben quienes tienen la paciencia de seguirme que vinculo todos mis artículos con comparaciones y paralelismos en el inacabable mundo wagneriano. He de confesar que en la redacción de este artículo la inspiración no me acompañó. Decidí preguntarle a ChatGPT y me sugirió que la mejor comparación de los peligros de la IA con el mundo wagneriano era la del anillo forjado por Alberich, capaz de dar poder a los humanos pero también de llevarlos a su destrucción.

Muy a mi pesar, tengo que reconocer que ChatGPT estaba en lo cierto y fue más creativo que yo. ~

- {{“El futuro de este planeta está en la Inteligencia Artificial”, entrevista a Xabi Uribe-Etxebarria publicada en El Mundo el 8 de marzo de 2020.}}

- ((“Yuval Noah Harari argues that ai has hacked the operating system of human civilisation”, The Economist, 28 de abril de 2013. Traducido en La Vanguardia el 3 de mayo de 2023.))

- {{Kai-Fu Lee, Superpotencias de la inteligencia artificial. China, Silicon Valley y el nuevo orden mundial, Barcelona, Deusto, 2020.}}

- {{Michael Ignatieff, “Calificar trabajos en el vacío”, ABC, 7 de mayo de 2023.}}

- ((Entrevista a Ramón López Mántaras publicada en DILEMATA, año 9 (2017), n.º 24, pp. 301-309.))

- {{Ibid.}}

- ((“El gran desafío de la IA es dotar de sentido común a las máquinas”, entrevista a Ramón López Mántaras publicada en El Cultural el 28 de abril de 2017.))

- {{Ignatieff, op. cit.}}

- {{Kai-Fu Lee, op. cit.}}

- ((Ignatieff, op. cit.))

es abogado del Estado (en excedencia) y experto en regulación y economía digital. Ha sido secretario de Estado de telecomunicaciones y director general de asuntos públicos de Telefónica. Preside la Comisión de

Digitalización de la Cámara de Comercio de España.